Arquitetura

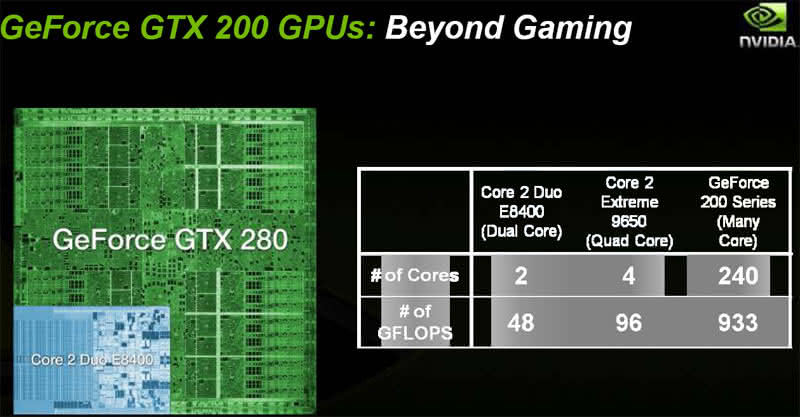

A NVIDIA está lançando hoje dois chips dentro da família GeForce GTX 200: o GTX 280 e o GTX 260. Na Figura 4 você pode ver um diagrama em blocos do novo GeForce GTX 280 e na Figura 5 uma foto da pastilha de silício do GeForce GTX 280 mostrando a localização dos principais blocos.

Figura 4: Diagrama em blocos do GeForce GTX 280.

Figure 5: Localização dos principais blocos na pastilha de silício do GeForce GTX 280.

No meio do diagrama em blocos na Figura 5 você pode ver 10 blocos. Esses blocos são chamados Thread Processing Cluster ou Cluster de Processamento de Threads ou simplesmente TPC e na Figura 7 você tem uma visão detalhada de um desses blocos.

Figura 6: Cluster de Processamento de Threads (TPC).

Cada TPC tem um cache de memória L1 e três conjuntos de unidades de processamento. Cada um desses conjuntos é chamado Streaming Multiprocessors (SM) ou Multiprocessadores Streaming pela NVIDIA. Cada conjunto tem oito unidades de processamento (chamadas “core” ou “núcleo” pela NVIDIA; elas também são chamadas de Streaming Processors ou Processadores de Streaming ou SP) compartilhando uma pequena quantidade de memória RAM (chamada “local memory” ou “memória local” pela NVIDIA). A inclusão dessas pequenas quantidades de memória RAM é uma das principais diferenças entre a arquitetura usada pela série GeForce GTX 200 e pelas séries GeForce 8 e GeForce 9. Você pode aprender mais sobre a arquitetura dessas duas séries em nosso artigo Arquitetura da Série GeForce 8 (apesar do seu nome, o GeForce 9 é baseado na arquitetura do GeForce 8).

A principal ideia por trás do DirectX 10 – isto é, o modelo de programação Shader 4.0 – é que cada unidade de processamento é uma unidade “genérica” permitindo qualquer tipo de processamento (este conceito ajudou muito o GPGPU). Antigamente o chip gráfico tinha unidades específicas para cada tipo de processamento possível (mais notavelmente as unidades de processamento específicas para sombreamento de pixels e unidades de processamento específicas para sombreamento de vértices).

Como cada conjunto dentro do TPC tem oito unidades de processamento, cada TPC tem 24 unidades de processamento, para um total de 240 unidades de processamento (10 TPCs) no GeForce GTX 280. O GeForce GTX 260 tem menos unidades, 192, obtidas com a utilização de oito TPCs em vez de 10.

Dentro de cada TPC você pode encontrar ainda oito unidades de filtragem de texturas (rotuladas “TF” na Figura 7), para um total de 80 unidades de textura na GeForce GTX 280 e 64 no GeForce GTX 260.

Como você pode ver na Figura 4, o GeForce GTX 280 tem oito unidades de interface com a memória, cada uma podendo transferir 64 bits. Isto significa que o GeForce GTX 280 tem uma interface de memória de 512 bits (64 bits x 8) – já estava na hora: o GeForce 8800 GTX usa uma interface de memória de 384 bits e o GeForce 9800 GTX usa uma interface de memória de 256 bits. Esse modelo suporta 1 GB de memória de vídeo, com um chip de 128 MB (1 Mbit) ligado a cada unidade de interface com a memória. O GeForce GTX 260 tem sete unidades de interface com a memória, o que significa que esta versão usa uma interface de memória de 448 bits (64 bits x 7) e vem com 896 MB de memória de vídeo (128 MB por chip x 7).

A série GeForce GTX 200 finalmente usa unidades de ponto flutuante de precisão dupla (ou seja, registradores de ponto flutuante de 64 bits).

Os chips da nova série GeForce GTX 200 vêm com o motor de processamento de vídeo 2D atualizado, chamado VP2 ou “PureVideo HD de 2ª geração”, que tem um decodificador H.264 totalmente baseado em hardware (usado para decodificar filmes de alta definição como Blu-Ray e HD-DVD), dispensando o uso do processador para esta tarefa. Este mesmo decodificador é encontrado em todas as placas de vídeo das séries GeForce 8 e 9, menos nos chips "G80" (GeForce 8800 GTS, GTX e Ultra), que são baseados no motor antigo do PureVideo HD, o VP1, que ainda usa parcialmente o processador da máquina para esta decodificação.

A série GeForce GTX 200 tem ainda mais modos de economia de energia. Quatro modos estão disponíveis:

- Modo ocioso/2D: usado quando você está trabalhando no Windows e executando programas comuns, como processamento de textos e navegando na internet. A placa de vídeo consome cerca de 25 W quando está neste modo.

- Modo de reprodução de vídeo: usado quando você quer assistir vídeos e usar o decodificador baseado em hardware incorporado no chip gráfico em vez de usar o processador do micro para decodificação. A placa de vídeo consome cerca de 35 W quando está neste modo.

- Modo de desempenho máximo 3D: Quando você roda jogos a placa de vídeo ativa seu modo 3D. O consumo de energia será o máximo (máximo de 236 W no GeForce GTX 280 e 182 W no GeForce GTX 260).

- HybridPower: Esta é uma tecnologia onde o vídeo 2D é produzido pela placa-mãe (ou seja, vídeo on-board) e a placa de vídeo é automaticamente desligada quando você não está rodando jogos. Portanto o consumo de energia da placa de vídeo é zero quando você não está rodando jogos. Você precisa de uma placa-mãe compatível com a tecnologia HybridPower para usufruir deste recurso.

Respostas recomendadas

Crie uma conta ou entre para comentar

Você precisa ser um usuário para fazer um comentário

Criar uma conta

Crie uma nova conta em nossa comunidade. É fácil!

Crie uma nova contaEntrar

Já tem uma conta? Faça o login.

Entrar agora