-

Posts

8.859 -

Cadastrado em

-

Última visita

Tipo de conteúdo

Artigos

Selos

Livros

Cursos

Análises

Fórum

Tudo que Gabriel Torres postou

-

Tópico para a discussão do seguinte conteúdo publicado no Clube do Hardware: Placa de Vídeo GeForce 6800 GT "Teste com o modelo de referência da NVIDIA do GeForce 6800 GT PCI Express." Comentários são bem-vindos. Atenciosamente, Equipe Clube do Hardware https://www.clubedohardware.com.br

-

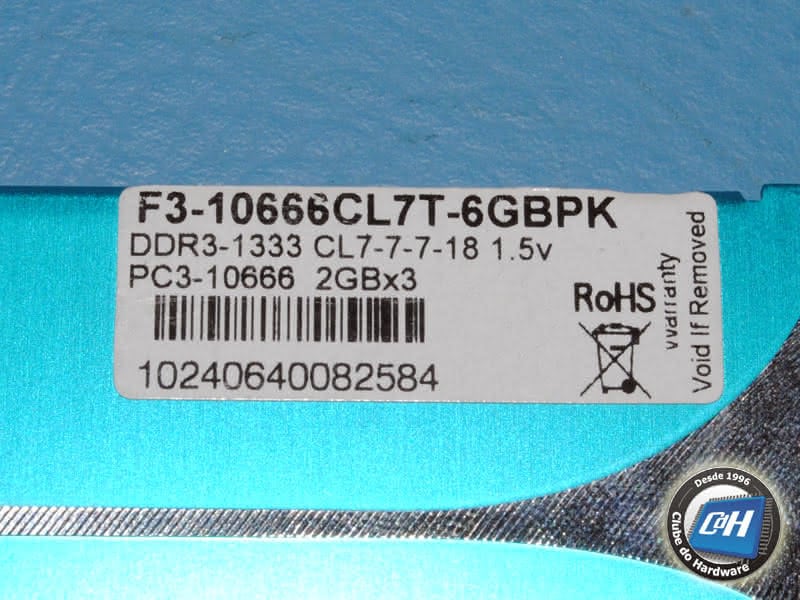

Este é um teste que estávamos devendo já há muito tempo. Trata-se da GeForce 6800 GT, que é uma versão mais barata da GeForce 6800 Ultra, a placa de vídeo topo de linha na série 6 da NVIDIA. A diferença entre estas duas placas está somente no clock, já que a arquitetura do chip gráfico é a mesma. Enquanto o GeForce 6800 Ultra roda a 400 MHz com memória a 1,1 GHz, a GeForce 6800 GT roda a 350 MHz com memória a 1 GHz. A diferença de clock é relativamente pouca, mas a diferença de preço é absurda. A GeForce 6800 Ultra não sai hoje por menos de US$ 490 nos EUA, enquanto a GeForce 6800 GT é encontrada na faixa de US$ 350. Nós recebemos da NVIDIA uma amostra da GeForce 6800 GT PCI Express fabricada pela própria NVIDIA para testes. Infelizmente não recebemos ainda para testes uma GeForce 6800 Ultra PCI Express, então não temos como saber a diferença de desempenho da GeForce 6800 GT para a GeForce 6800 Ultra. Como o PCI Express é um novo barramento, que necessita de uma nova placa-mãe, não é possível comparar diretamente os resultados de placas de vídeo PCI Express com placas de vídeo AGP. Por isso você não encontrará em nossos testes comparações das placas de vídeo PCI Express com outros modelos de placas de vídeo AGP que já testamos, já que a comparação direta não é possível. Há no mercado algumas poucas placas-mães que trazem os dois barramentos juntos, mas segundo os fabricantes de placas-mães o slot AGP deste tipo de placa é até 20% mais lento, já que ele não é nativamente AGP, isto é, usa um chip para converter os sinais do barramento PCI Express em sinais do barramento AGP. Ou seja, mesmo que usássemos uma placa-mãe dessas em nossos testes, a comparação não seria justa. Em nossos testes de placas de vídeo anteriores nós colocávamos várias tabelas comparativas. O problema é que quando um novo chip era lançado, as tabelas de todos os nossos testes ficavam desatualizadas. Para resolver este problema, criamos dois tutoriais, um contendo uma tabela atualizada de todos os chips da NVIDIA e outro contendo uma tabela atualizada de todos os chips da ATI. Veja, portanto, estes dois tutoriais caso queira ver qual é a diferença do GeForce 6800 GT para os demais chips da NVIDIA e como são suas características em comparação aos chips da concorrente ATI. É importante ter em mente que os chips gráficos da série 6 e 7 da NVIDIA usam motor gráfico Shader 3.0 (DirectX 9.0c), enquanto todos os chips da ATI são Shader 2.0 (DirectX 9.0). Um ponto importante a ser sempre lembrado é que a coluna "clock da memória" dessas tabelas informa o clock que o fabricante (ATI ou NVIDIA) recomenda que seja usado. Em alguns casos, sobretudo nas placas de vídeo mais baratas usando chips mais simples, alguns fabricantes usam chips de memória mais simples (com a finalidade de reduzir o custo da placa) e com clocks inferiores ao recomendado (compatível com os chips de memória mais simples), fazendo com que a placa obtenha um desempenho inferior ao de outras placas que usem o mesmo chip e que tenham a memória rodando na freqüência recomendada. Por este motivo, em nossos testes daqui para a frente estaremos sempre testando os clocks da placa de vídeo com o auxílio do programa PowerStrip, para ver se a placa está rodando com os clocks padrão ou se com um clock inferior. No caso da GeForce 6800 GT da NVIDIA, ela usa os clocks recomendados pela NVIDIA, 350 MHz para o chip e 500 MHz (1 GHz DDR) para a memória. O modelo de referência que testamos da NVIDIA você confere nas figuras abaixo. Figura 1: GeForce 6800 GT. Figura 2: GeForce 6800 GT, vista de costas. Figura 3: Detalhe do conector SLI. A GeForce 6800 GT é uma placa "fina", não ocupando o slot localizado ao lado do PCI Express x16. Nós desmontamos o dissipador de calor da placa para ver como era o contato dele com os chips de memória. Você confere ele na Figura 4 e como você pode perceber, ele usa fita térmica no contato com os chips. Figura 4: Dissipador de calor do modelo de referência. A memória usada é GDDR3 da Samsung de 2 ns que, segundo o fabricante, roda até 1 GHz. Como o GeForce 6800 GT acessa a memória a 1 GHz não há espaço para um overclock da memória dentro de suas especificações. É claro que você poderá experimentar colocar a memória rodando acima de suas especificações. Figura 5: Memória GDDR3 de 2 ns da Samsung usada pelo modelo de referência. A placa tem três conectores: dois DVI (para monitores de cristal líquido) e um S-Video. Você tem que instalar um adaptador em uma das saídas DVI para usar monitores com entrada VGA padrão. Você pode instalar até dois monitores de vídeo, usando adaptadores, se necessário. Ou seja, com ela você pode usar dois monitores ao mesmo tempo, como se tivesse duas placas de vídeo no micro, permitindo inclusive o uso de uma única área de trabalho nos dois monitores (clique aqui para ler mais sobre esse recurso). Antes de irmos aos nossos testes com esta placa, vamos recapitular suas principais características. Processador: GeForce 6800 GT, rodando a 350 MHz. Memória: 256 MB GDDR3 de 2 ns da Samsung (K4J55323QF-GC20), rodando a 1 GHz. Conexão: PCI Express x16. Conectores: Dois DVI e um S-Video out. Número de CDs que acompanha a placa: Não aplicável (o modelo que recebemos era o de referência do fabricante). Jogos que acompanham a placa: Não aplicável (o modelo que recebemos era o de referência do fabricante). Programas que acompanham a placa: Não aplicável (o modelo que recebemos era o de referência do fabricante). Mais informações: http://www.nvidia.com/page/geforce_6800.html Preço Médio nos EUA*: US$ 364,50. * Pesquisado em http://www.pricewatch.com no dia da publicação deste teste. Este preço é apenas uma referência para comparação com outras placas. O preço no Brasil será sempre maior, pois devemos adicionar o câmbio, o frete e os impostos, além da margem de lucro do distribuidor e do lojista. Em nossos testes de desempenho usamos a configuração listada abaixo. Entre as nossas sessões de teste o único dispositivo diferente era a placa de vídeo que estava sendo testada. Entre cada sessão de teste reformatamos o disco rígido e reinstalamos todos os programas, em seguida desfragmentamos o disco rígido. Configuração de Hardware Placa-mãe: DFI LAN Party 925X-T2 (Intel 925X, BIOS de 20 de setembro de 2004) Processador: Pentium 4 3,4 GHz LGA 775 Memória: Dois módulos DDR2-533 Corsair CM2X512-4200 CL4 de 512 MB cada Disco rígido: Maxtor DiamondMax 9 Plus (60 GB, ATA-133) Resolução de vídeo: 1024x768x32@85 Hz Configuração de Software Windows XP Professional em português, instalado em NTFS Service Pack 2 Direct X 9.0c Versão do driver inf da Intel: 6.0.1.1002 Versão do driver de vídeo ATI: 4.10 (6.14.10.6483) Versão do driver de vídeo ATI: 4.12 (Radeon X850 Platinum Edition) Versão do driver de vídeo NVIDIA: 66.93 (6.6.9.3) Programas Usados 3DMark2001 SE 3DMark03 Business versão 3.50 3DMark05 Business versão 1.10 Doom 3 Far Cry versão 1.3 X2 - The Threat Adotamos uma margem de erro de 3%. Com isso, diferenças de desempenho inferiores a 3% não podem ser consideradas significativas. Em outras palavras, produtos onde a diferença de desempenho seja inferior a 3% deverão ser considerados como tendo desempenhos similares. O 3Dmark2001 SE mede o desempenho simulando jogos baseados DirectX 8.1. Ele continua sendo um bom programa para avaliar o desempenho de jogos da geração passada, programados em DirectX 8. Neste programa nós executamos seis testes. Rodamos o programa em três resoluções, 1024x768x32, 1280x1024x32 e 1600x1200x32, primeiro sem antialiasing e sem frame buffer, e depois colocando o antialiasing em 4 samples e o frame buffer em triplo. Isso faz aumentar a qualidade da imagem, mas diminui o desempenho. Queríamos ver justamente o quanto de desempenho perdíamos quando colocamos a placa de vídeo para trabalhar com o máximo de qualidade possível. Importante notar que os chips da ATI permitem que o anti-aliasing seja configurado em até 6x. Como os chips da NVIDIA não permitem essa configuração, tivemos de manter a configuração de alta qualidade em 4x, de forma a adotarmos uma configuração que seja válida para todos os chips, fazendo com que a comparação seja válida. Você pode estar se perguntando o motivo de incluirmos um programa "obsoleto" entre os nossos testes de placas de vídeo de última geração. Para nós, tão importante quanto saber o desempenho das placas de vídeo com jogos mais modernos é saber o desempenho da placa quando um jogo mais antigo é executado. Por isto mantivemos este programa em nossa metodologia. Na configuração de 1024x768 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 7,74% mais rápida do que a Radeon X700 Pro, 12,25% mais rápida do que a GeForce 6600 GT da XFX, 12,43% mais rápida do que a GeForce 6600 GT da Gigabyte, 12,54% mais rápida do que a GeForce 6600 GT da Leadtek, 13,94% mais rápida do que a GeForce 6600 GT da NVIDIA, 38,88% mais rápida do que a Radeon X600 XT, 42,03% mais rápida do que a GeForce 6600 da Albatron, 43,24% mais rápida do que a GeForce 6600 da Pixelview, 60,00% mais rápida do que a Radeon X600 Pro, e 203,94% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 14,61% mais rápida. Na configuração de 1280x1024 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 17,27% mais rápida do que a Radeon X700 Pro, 17,82% mais rápida do que a GeForce 6600 GT da Leadtek, 18,02% mais rápida do que a GeForce 6600 GT da Gigabyte, 19,00% mais rápida do que a GeForce 6600 GT da NVIDIA, 19,22% mais rápida do que a GeForce 6600 GT da XFX, 61,68% mais rápida do que a GeForce 6600 da Albatron, 62,23% mais rápida do que a GeForce 6600 da Pixelview, 63,53% mais rápida do que a Radeon X600 XT, 94,64% mais rápida do que a Radeon X600 Pro, e 311,89% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 13,19% mais rápida. Na configuração de 1600x1200 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 22,18% mais rápida do que a GeForce 6600 GT da Leadtek, 22,56% mais rápida do que a GeForce 6600 GT da XFX, 22,63% mais rápida do que a GeForce 6600 GT da NVIDIA, 23,18% mais rápida do que a GeForce 6600 GT da Gigabyte, 31,73% mais rápida do que a Radeon X700 Pro da Sapphire, 85,27% mais rápida do que a GeForce 6600 da Albatron, 87,43% mais rápida do que a GeForce 6600 da Pixelview, 106,47% mais rápida do que a Radeon X600 XT, 149,43% mais rápida do que a Radeon X600 Pro, e 502,01% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 15,48% mais rápida. Na configuração de 1024x768 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 9,10% mais rápida do que a Radeon X700 Pro, 25,59% mais rápida do que a GeForce 6600 GT da Leadtek, 26,00% mais rápida do que a GeForce 6600 GT da Gigabyte, 26,05% mais rápida do que a GeForce 6600 GT da XFX, 26,73% mais rápida do que a GeForce 6600 GT da NVIDIA, 76,86% mais rápida do que a Radeon X600 XT, 92,51% mais rápida do que a GeForce 6600 da Albatron, 94,45% mais rápida do que a GeForce 6600 da Pixelview, 109,34% mais rápida do que a Radeon X600 Pro da Sapphire, e 346,18% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 18,71% mais rápida. Na configuração de 1280x1024 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 22,27% mais rápida do que a Radeon X700 Pro da Sapphire, 44,15% mais rápida do que a GeForce 6600 GT da XFX, 44,16% mais rápida do que a GeForce 6600 GT da NVIDIA, 44,37% mais rápida do que a GeForce 6600 GT da Gigabyte, 45,09% mais rápida do que a GeForce 6600 GT da Leadtek, 118,61% mais rápida do que a Radeon X600 XT, 149,91% mais rápida do que a GeForce 6600 da Albatron, 151,95% mais rápida do que a GeForce 6600 da Pixelview, 162,68% mais rápida do que a Radeon X600 Pro da Sapphire, e 485,70% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 22,03% mais rápida. Na configuração de 1600x1200 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 25,11% mais rápida do que a Radeon X700 Pro da Sapphire, 78,69% mais rápida do que a GeForce 6600 GT da XFX, 78,90% mais rápida do que a GeForce 6600 GT da Gigabyte, 79,12% mais rápida do que a GeForce 6600 GT da Leadtek, 79,31% mais rápida do que a GeForce 6600 GT da NVIDIA, 232,46% mais rápida do que a GeForce 6600 da Albatron, 235,29% mais rápida do que a GeForce 6600 da Pixelview, 269,08% mais rápida do que a Radeon X600 XT, 353,91% mais rápida do que a Radeon X600 Pro, e 1.100,91% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 37,79% mais rápida. O 3Dmark03 mede o desempenho simulando jogos escritos para o DirectX 9, que são os jogos contemporâneos. Rodamos o programa em três resoluções, 1024x768x32, 1280x1024x32 e 1600x1200x32, primeiro sem antialiasing e filtragem anisotrópica, e depois colocando o antialiasing em 4x e a filtragem anisotrópica também em 4x. Isso faz aumentar a qualidade da imagem, mas diminui o desempenho. Queríamos ver justamente o quanto de desempenho perdíamos quando colocamos a placa de vídeo para trabalhar com o máximo de qualidade possível. Importante notar que os chips da ATI permitem que o anti-aliasing seja configurado em até 6x. Como os chips da NVIDIA não permitem essa configuração, tivemos de manter a configuração de alta qualidade em 4x, de forma a adotarmos uma configuração que seja válida para todos os chips, fazendo com que a comparação seja válida. Na configuração de 1024x768 sem recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 39,31% mais rápida do que a GeForce 6600 GT da XFX, 39,36% mais rápida do que a GeForce 6600 GT da Gigabyte, 39,36% mais rápida do que a GeForce 6600 GT da NVIDIA, 39,50% mais rápida do que a GeForce 6600 GT da Leadtek, 53,85% mais rápida do que a Radeon X700 Pro, 131,55% mais rápida do que a GeForce 6600 da Albatron, 134,25% mais rápida do que a GeForce 6600 da Pixelview, 171,88% mais rápida do que a Radeon X600 XT, 223,62% mais rápida do que a Radeon X600 Pro, e 527,33% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 13,89% mais rápida. Na configuração de 1280x1024 sem recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 46,15% mais rápida do que a GeForce 6600 GT da Gigabyte, 46,27% mais rápida do que a GeForce 6600 GT da XFX, 46,34% mais rápida do que a GeForce 6600 GT da Leadtek, 46,75% mais rápida do que a GeForce 6600 GT da NVIDIA, 65,13% mais rápida do que a Radeon X700 Pro, 149,75% mais rápida do que a GeForce 6600 da Albatron, 152,75% mais rápida do que a GeForce 6600 da Pixelview, 195,52% mais rápida do que a Radeon X600 XT, 252,45% mais rápida do que a Radeon X600 Pro, e 623,08% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 16,73% mais rápida. Na configuração de 1600x1200 sem recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 53,93% mais rápida do que a GeForce 6600 GT da Gigabyte, 53,97% mais rápida do que a GeForce 6600 GT da XFX, 53,97% mais rápida do que a GeForce 6600 GT da Leadtek, 54,23% mais rápida do que a GeForce 6600 GT da NVIDIA, 81,41% mais rápida do que a Radeon X700 Pro, 166,77% mais rápida do que a GeForce 6600 da Albatron, 170,61% mais rápida do que a GeForce 6600 da Pixelview, 235,24% mais rápida do que a Radeon X600 XT, 297,55% mais rápida do que a Radeon X600 Pro, e 971,06% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 17,74% mais rápida. Na configuração de 1024x768 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 65,21% mais rápida do que a GeForce 6600 GT da Leadtek, 65,41% mais rápida do que a GeForce 6600 GT da Gigabyte, 65,65% mais rápida do que a GeForce 6600 GT da XFX, 66,00% mais rápida do que a GeForce 6600 GT da NVIDIA, 102,84% mais rápida do que a Radeon X700 Pro, 190,96% mais rápida do que a GeForce 6600 da Albatron, 194,43% mais rápida do que a GeForce 6600 da Pixelview, 251,93% mais rápida do que a Radeon X600 XT, 313,32% mais rápida do que a Radeon X600 Pro, e 817,64% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 17,18% mais rápida. Na configuração de 1280x1024 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 103,06% mais rápida do que a GeForce 6600 GT da XFX, 103,30% mais rápida do que a GeForce 6600 GT da Leadtek, 103,62% mais rápida do que a GeForce 6600 GT da Gigabyte, 104,51% mais rápida do que a GeForce 6600 GT da NVIDIA, 110,76% mais rápida do que a Radeon X700 Pro, 245,49% mais rápida do que a GeForce 6600 da Albatron, 249,93% mais rápida do que a GeForce 6600 da Pixelview, 282,83% mais rápida do que a Radeon X600 XT, 326,73% mais rápida do que a Radeon X600 Pro, e 936,47% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 21,38% mais rápida. Na configuração de 1600x1200 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 122,60% mais rápida do que a Radeon X700 Pro da Sapphire, 133,20% mais rápida do que a GeForce 6600 GT da Gigabyte, 133,88% mais rápida do que a GeForce 6600 GT da NVIDIA, 134,01% mais rápida do que a GeForce 6600 GT da XFX e da Leadtek, 291,24% mais rápida do que a GeForce 6600 da Albatron, 295,86% mais rápida do que a GeForce 6600 da Pixelview, 448,91% mais rápida do que a Radeon X600 XT, 487,43% mais rápida do que a Radeon X600 Pro, e 1.609,79% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 25,04% mais rápida. O 3Dmark05 mede o desempenho simulando jogos escritos para o DirectX 9.0c, ou seja, usando o modelo Shader 3.0. Este modelo de programação é usado pelo jogo Far Cry e por jogos que serão lançados em 2005. Atualmente somente os chips da NVIDIA da série 6 (6600, 6800 etc) são Shader 3.0. Os chips concorrentes da ATI continuam sendo Shader 2.0. Rodamos o programa em três resoluções, 1024x768x32, 1280x1024x32 e 1600x1200x32, primeiro sem antialiasing e filtragem anisotrópica, e depois colocando o antialiasing em 4x e a filtragem anisotrópica também em 4x. Isso faz aumentar a qualidade da imagem, mas diminui o desempenho. Queríamos ver justamente o quanto de desempenho perdíamos quando colocamos a placa de vídeo para trabalhar com o máximo de qualidade possível. Importante notar que os chips da ATI permitem que o anti-aliasing seja configurado em até 6x. Como os chips da NVIDIA não permitem essa configuração, tivemos de manter a configuração de alta qualidade em 4x, de forma a adotarmos uma configuração que seja válida para todos os chips, fazendo com que a comparação seja válida. Na configuração de 1024x768 sem recursos de aumento de qualidade de imagem, GeForce 6800 GT da NVIDIA foi 56,99% mais rápida do que a GeForce 6600 GT da NVIDIA, 57,21% mais rápida do que a Radeon X700 Pro, 57,53% mais rápida do que a GeForce 6600 GT da Gigabyte, 57,53% mais rápida do que a GeForce 6600 GT da Leadtek, 57,97% mais rápida do que a GeForce 6600 GT da XFX, 166,73% mais rápida do que a GeForce 6600 da Albatron, 170,22% mais rápida do que a GeForce 6600 da Pixelview, 216,61% mais rápida do que a Radeon X600 XT, 232,38% mais rápida do que a Radeon X600 Pro, e 491,53% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 26,34% mais rápida. Na configuração de 1280x1024 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 66,22% mais rápida do que a Radeon X700 Pro, 90,68% mais rápida do que a GeForce 6600 GT da Leadtek, 90,78% mais rápida do que a GeForce 6600 GT da NVIDIA, 91,36% mais rápida do que a GeForce 6600 GT da XFX, 92,94% mais rápida do que a GeForce 6600 GT da Gigabyte, 197,46% mais rápida do que a GeForce 6600 da Albatron, 198,17% mais rápida do que a GeForce 6600 da Pixelview, 260,10% mais rápida do que a Radeon X600 Pro, 277,52% mais rápida do que a Radeon X600 XT, e 550,17% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 26,57% mais rápida. Na configuração de 1600x1200 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 72,78% mais rápida do que a Radeon X700 Pro, 136,68% mais rápida do que a GeForce 6600 GT da Gigabyte, 137,04% mais rápida do que a GeForce 6600 GT da NVIDIA, 139,98% mais rápida do que a GeForce 6600 GT da Leadtek, 144,54% mais rápida do que a GeForce 6600 GT da XFX, 227,44% mais rápida do que a GeForce 6600 da Albatron, 231,65% mais rápida do que a GeForce 6600 da Pixelview, 279,73% mais rápida do que a Radeon X600 Pro da Sapphire, 336,58% mais rápida do que a Radeon X600 XT, e 599,32% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 27,18% mais rápida. Na configuração de 1024x768 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 65,77% mais rápida do que a Radeon X700 Pro, 187,49% mais rápida do que a GeForce 6600 GT da XFX, 195,76% mais rápida do que a GeForce 6600 GT da Gigabyte, 196,00% mais rápida do que a GeForce 6600 GT da Leadtek, 203,03% mais rápida do que a GeForce 6600 GT da NVIDIA, 256,45% mais rápida do que a Radeon X600 Pro, 289,06% mais rápida do que a GeForce 6600 da Pixelview, 295,72% mais rápida do que a GeForce 6600 da Albatron, 309,75% mais rápida do que a Radeon X600 XT, e 617,05% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 34,35% mais rápida. Na configuração de 1280x1024 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 72,42% mais rápida do que a Radeon X700 Pro, 269,74% mais rápida do que a Radeon X600 Pro, 411,02% mais rápida do que a Radeon X600 XT, e 689,63% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 35,67% mais rápida. Nessa configuração, as placas precisavam ter 256MB de memória para rodar o teste. As placas GeForce 6600 GT da XFX, GeForce 6600 GT da Gigabyte, GeForce 6600 GT da Leadtek, GeForce 6600 GT da NVIDIA, GeForce 6600 da Pixelview e a GeForce 6600 da Albatron, tinham apenas 128MB de memória e por isso ficaram fora desta etapa do teste. Na configuração de 1600x1200 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 62,52% mais rápida do que a Radeon X700 Pro, 279,12% mais rápida do que a Radeon X600 Pro, 554,84% mais rápida do que a Radeon X600 XT, e 862,50% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 48,90% mais rápida. Nessa configuração, as placas também precisavam ter 256MB de memória para rodar o teste. As placas GeForce 6600 GT da XFX, GeForce 6600 GT da Gigabyte, GeForce 6600 GT da Leadtek, GeForce 6600 GT da NVIDIA, GeForce 6600 da Pixelview e a GeForce 6600 da Albatron, tinham apenas 128MB de memória e por isso ficaram fora desta etapa do teste. Rodamos o demo do jogo X2 - The Threat, que é um jogo extremamente "pesado" e representa a complexidade gráfica dos jogos de última geração, sendo baseado no DirectX 9.0 (Shader 2.0). Ele roda várias fases do jogo e apresenta ao final a média de quadros por segundo gerados. Rodamos o programa em três resoluções, 1024x768x32, 1280x1024x32 e 1600x1200x32, primeiro sem qualquer recurso de aumento de qualidade de imagem, e depois aumentando a qualidade de imagem, pois normalmente quando aumentamos a qualidade de imagem, o desempenho cai. O aumento de qualidade consistiu em ativar o anti-aliasing e o sombreamento. Na configuração de 1024x768 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 11,88% mais rápida do que a GeForce 6600 GT da NVIDIA, 12,00% mais rápida do que a GeForce 6600 GT da Leadtek, 12,45% mais rápida do que a GeForce 6600 GT da XFX, 12,61% mais rápida do que a GeForce 6600 GT da Gigabyte, 30,35% mais rápida do que a Radeon X700 Pro, 51,90% mais rápida do que a GeForce 6600 da Albatron, 53,26% mais rápida do que a GeForce 6600 da Pixelview, 70,88% mais rápida do que a Radeon X600 XT, 100,27% mais rápida do que a Radeon X600 Pro, e 259,02% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 6,26% mais rápida. Na configuração de 1280x1024 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 17,85% mais rápida do que a GeForce 6600 GT da Leadtek, 17,90% mais rápida do que a GeForce 6600 GT da NVIDIA, 18,19% mais rápida do que a GeForce 6600 GT da XFX, 18,20% mais rápida do que a GeForce 6600 GT da Gigabyte, 43,29% mais rápida do que a Radeon X700 Pro, 75,74% mais rápida do que a GeForce 6600 da Albatron, 77,66% mais rápida do que a GeForce 6600 da Pixelview, 102,73% mais rápida do que a Radeon X600 XT, 141,79% mais rápida do que a Radeon X600 Pro, e 357,67% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 6,86% mais rápida. Na configuração de 1600x1200 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 38,53% mais rápida do que a GeForce 6600 GT da Leadtek, 38,54% mais rápida do que a GeForce 6600 GT da NVIDIA, 38,83% mais rápida do que a GeForce 6600 GT da Gigabyte, 38,86% mais rápida do que a GeForce 6600 GT da XFX, 75,99% mais rápida do que a Radeon X700 Pro, 121,96% mais rápida do que a GeForce 6600 da Albatron, 124,27% mais rápida do que a GeForce 6600 da Pixelview, 168,51% mais rápida do que a Radeon X600 XT, 223,41% mais rápida do que a Radeon X600 Pro, e 557,48% mais rápida do que a Radeon X300. O desempenho da Radeon X850 XT Platinum Edition foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. Na configuração de 1024x768 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 27,69% mais rápida do que a GeForce 6600 GT da XFX, 28,13% mais rápida do que a GeForce 6600 GT da Gigabyte, 29,40% mais rápida do que a GeForce 6600 GT da NVIDIA, 44,88% mais rápida do que a GeForce 6600 GT da Leadtek, 57,29% mais rápida do que a Radeon X700 Pro, 93,24% mais rápida do que a GeForce 6600 da Pixelview, 94,28% mais rápida do que a GeForce 6600 da Albatron, 102,89% mais rápida do que a Radeon X600 XT, 135,67% mais rápida do que a Radeon X600 Pro, e 352,65% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 4,31% mais rápida. Na configuração de 1280x1024 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 34,14% mais rápida do que a GeForce 6600 GT da Gigabyte, 34,64% mais rápida do que a GeForce 6600 GT da XFX, 34,77% mais rápida do que a GeForce 6600 GT da NVIDIA, 36,80% mais rápida do que a GeForce 6600 GT da Leadtek, 69,38% mais rápida do que a Radeon X700 Pro, 111,59% mais rápida do que a GeForce 6600 da Albatron, 114,97% mais rápida do que a GeForce 6600 da Pixelview, 121,40% mais rápida do que a Radeon X600 XT, 160,00% mais rápida do que a Radeon X600 Pro, e 431,23% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 7,52% mais rápida. Na configuração de 1600x1200 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 40,65% mais rápida do que a GeForce 6600 GT da NVIDIA, 40,70% mais rápida do que a GeForce 6600 GT da Gigabyte, 40,75% mais rápida do que a GeForce 6600 GT da Leadtek, 40,81% mais rápida do que a GeForce 6600 GT da XFX, 79,69% mais rápida do que a Radeon X700 Pro, 124,62% mais rápida do que a GeForce 6600 da Albatron, 130,24% mais rápida do que a GeForce 6600 da Pixelview, 195,86% mais rápida do que a Radeon X600 XT, 250,90% mais rápida do que a Radeon X600 Pro, e 698,15% mais rápida do que a Radeon X300. A GeForce 6800 GT da NVIDIA perdeu apenas para a Radeon X850 XT Platinum Edition, que foi 10,96% mais rápida. O Doom 3 é um dos jogos mais pesados existentes atualmente. Assim como nos fizemos nos demais programas, rodamos este jogo em três resoluções, 1024x768x32, 1280x1024x32 e 1600x1200x32. Este jogo permite vários níveis de qualidade de imagem, e fizemos nossos testes em dois níveis, low e high. Rodamos o demo1 quatro vezes e anotamos a quantidade de quadros por segundo obtida. O primeiro resultado nós descartamos de cara, pois ele é bem inferior ao das demais rodadas. Isso ocorre porque na primeira vez em que rodamos o demo o jogo tem que carregar as texturas para a memória de vídeo da placa testada, coisa que não ocorre da segunda vez em diante em que o mesmo demo é rodado. Dos três resultados que sobraram, aproveitamos o resultado com valor intermediário, isto é, descartamos o maior e o menor valor. Interessante notar que na maioria das vezes os valores obtidos pela segunda rodada em diante eram os mesmos. Um detalhe importante que não podemos deixar de comentar é que o Doom 3 possui uma trava interna da quantidade de quadros por segundo que ele é capaz de gerar durante uma sessão normal de jogo: ele só gera 60 quadros por segundo, mesmo que sua placa possa gerar mais. Isso foi feito justamente para o jogo ter uma mesma sensação de "jogabilidade" independentemente da placa de vídeo instalada. Esta trava, entretanto, não atua no modo de medida de desempenho do jogo. Para mais detalhes de como efetuar testes de desempenho 3D com o Doom 3, leia a nossa dica sobre o assunto. Na configuração de 1024x768 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 7,96% mais rápida do que a GeForce 6600 GT da Gigabyte e da NVIDIA, 8,53% mais rápida do que a GeForce 6600 GT da Leadtek, 8,96% mais rápida do que a GeForce 6600 GT da XFX, 48,74% mais rápida do que a Radeon X700 Pro, 52,87% mais rápida do que a GeForce 6600 da Albatron, 54,29% mais rápida do que a GeForce 6600 da Pixelview, 167,64% mais rápida do que a Radeon X600 XT, 228,17% mais rápida do que a Radeon X600 Pro, e 494,96% mais rápida do que a Radeon X300. O desempenho da Radeon X850 XT Platinum Edition foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. Na configuração de 1280x1024 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 25,29% mais rápida do que a GeForce 6600 GT da Gigabyte e da NVIDIA, 25,70% mais rápida do que a GeForce 6600 GT da Leadtek, 26,54% mais rápida do que a GeForce 6600 GT da XFX, 103,22% mais rápida do que a Radeon X700 Pro, 107,10% mais rápida do que a GeForce 6600 da Albatron, 109,39% mais rápida do que a GeForce 6600 da Pixelview, 286,73% mais rápida do que a Radeon X600 XT, 373,75% mais rápida do que a Radeon X600 Pro, e 761,36% mais rápida do que a Radeon X300. O desempenho da Radeon X850 XT Platinum Edition foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. Na configuração de 1600x1200 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 3,21% mais rápida do que a RAdeon X850 XT Platinum Edition, 40,31% mais rápida do que a GeForce 6600 GT, 143,02% mais rápida do que a GeForce 6600 da Albatron, 145,80% mais rápida do que a GeForce 6600 da Pixelview, 152,55% mais rápida do que a Radeon X700 Pro, 391,60% mais rápida do que a Radeon X600 XT, 507,55% mais rápida do que a Radeon X600 Pro, e 1.115,09% mais rápida do que a Radeon X300. Na configuração de 1024x768 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 15,40% mais rápida do que a GeForce 6600 GT da XFX, 15,72% mais rápida do que a GeForce 6600 GT da Gigabyte, 16,88% mais rápida do que a GeForce 6600 GT da Leadtek, 17,39% mais rápida do que a GeForce 6600 GT da NVIDIA, 62,10% mais rápida do que a Radeon X700 Pro, 67,76% mais rápida do que a GeForce 6600 da Albatron, 69,50% mais rápida do que a GeForce 6600 da Pixelview, 193,88% mais rápida do que a Radeon X600 XT, 256,77% mais rápida do que a Radeon X600 Pro, e 548,41% mais rápida do que a Radeon X300. O desempenho da Radeon X850 XT Platinum Edition foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. Na configuração de 1280x1024 com recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 30,45% mais rápida do que a GeForce 6600 GT da XFX, 31,40% mais rápida do que a GeForce 6600 GT da Leadtek, 32,60% mais rápida do que a GeForce 6600 GT da Gigabyte, 32,84% mais rápida do que a GeForce 6600 GT da NVIDIA, 110,47% mais rápida do que a Radeon X700 Pro, 116,77% mais rápida do que a GeForce 6600 da Albatron, 118,73% mais rápida do que a GeForce 6600 da Pixelview, 293,48% mais rápida do que a Radeon X600 XT, 382,67% mais rápida do que a Radeon X600 Pro, e 782,93% mais rápida do que a Radeon X300. O desempenho da Radeon X850 XT Platinum Edition foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. Na configuração de 1600x1200 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 40,78% mais rápida do que a GeForce 6600 GT, 144,40% mais rápida do que a GeForce 6600 da Albatron, 146,37% mais rápida do que a GeForce 6600 da Pixelview, 153,53% mais rápida do que a Radeon X700 Pro, 426,72% mais rápida do que a Radeon X600 XT, 493,20% mais rápida do que a Radeon X600 Pro, e 1.146,94% mais rápida do que a Radeon X300. O desempenho da Radeon X850 XT Platinum Edition foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. O Far Cry é um jogo baseado no modelo Shader 3.0 (DirectX 9.0c), modelo de programação presente nos chips das séries 6 e 7 da NVIDIA e nos chips da série X1000 da ATI. Fizemos a atualização do jogo para a versão 1.3. Assim como nos fizemos nos demais programas, rodamos este jogo em três resoluções, 1024x768x32, 1280x1024x32 e 1600x1200x32. Este jogo permite vários níveis de qualidade de imagem, e fizemos nossos testes em dois níveis, low e very high. Para efetuarmos a medida de desempenho usamos o demo criado pela revista alemã PC Games Hardware (PCGH), disponível em http://www.3dcenter.org/downloads/farcry-pcgh-vga.php. Rodamos este demo quatro vezes e fizemos uma média aritmética, sendo esta média o resultado que apresentamos. Este jogo tem um detalhe importantíssimo em sua configuração de qualidade de imagem. O anti-aliasing, em vez de ser configurado numericamente (1x, 2x, 4x ou 6x) é configurado como low, medium ou high. O problema é que em chips da NVIDIA, tanto medium quanto high significa 4x, enquanto que em chips da ATI medium significa 2x e high significa 6x, tornando a comparação entre chips da ATI e da NVIDIA injusta. Por este motivo nós configuramos o antialiasing em 4x e a filtragem anisotrópica em 8x manualmente através do painel de controle do driver. Para mais detalhes de como efetuar testes de desempenho 3D com o Far Cry, leia a nossa dica sobre o assunto. Na configuração de 1024x768 sem recursos de aumento de qualidade de imagem, a GeForce 6600 da Albatron foi 7,15% mais rápida do que a Radeon X600 Pro, e 105,24% mais rápida do que a Radeon X300. A GeForce 6600, tanto o modelo da Albatron quanto o modelo da Pixelview tiveram praticamente o mesmo desempenho da GeForce 6800 GT da NVIDIA. A GeForce 6800 GT da NVIDIA perdeu para as demais placas do teste: a Radeon X850 XT Platinum Edition foi 20,70% mais rápida, a Radeon X700 Pro foi 20,21% mais rápida, a Radeon X600 XT foi 10,12% mais rápida, a GeForce 6600 GT da Leadtek foi 9,72% mais rápida, a GeForce 6600 GT da Gigabyte foi 6,64% mais rápida, a GeForce 6600 GT da NVIDIA foi 8,33% mais rápida, e por fim a GeForce 6600 GT da XFX foi 8,19% mais rápida do que a placa testada. Na configuração de 1280x1024 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 43,24% mais rápida do que a Radeon X600 XT, 45,41% mais rápida do que a GeForce 6600 da Albatron, 45,87% mais rápida do que a GeForce 6600 da Pixelview, 75,04% mais rápida do que a Radeon X600 Pro, e 243,21% mais rápida do que a Radeon X300. O desempenho da GeForce 6600 GT foi praticamente o mesmo da GeForce 6800 GT da NVIDIA. A GeForce 6800 GT da NVIDIA perdeu para a Radeon X850 XT Platinum Edition e para a Radeon X700 Pro, que foram, respectivamente, 12,12% e 8,39% mais rápida. Na configuração de 1600x1200 sem recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 16,17% mais rápida do que a GeForce 6600 GT da Gigabyte, 16,57% mais rápida do que a GeForce 6600 GT da Leadtek, 16,78% mais rápida do que a GeForce 6600 GT da XFX, 17,10% mais rápida do que a GeForce 6600 GT da NVIDIA, 21,31% mais rápida do que a Radeon X700 Pro, 101,42% mais rápida do que a GeForce 6600 da Albatron, 101,99% mais rápida do que a GeForce 6600 da Pixelview, 113,37% mais rápida do que a Radeon X600 XT, 161,29% mais rápida do que a Radeon X600 Pro, e 467,04% mais rápida do que a Radeon X300. A Radeon X850 XT Platinum Edition foi 12,50% mais rápida do que a GeForce 6800 GT da NVIDIA. Na configuração de 1024x768 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 66,82% mais rápida do que a Radeon X700 Pro, 73,73% mais rápida do que a GeForce 6600 GT da Gigabyte, 77,22% mais rápida do que a GeForce 6600 GT da Leadtek, 77,46% mais rápida do que a GeForce 6600 GT da XFX, 77,83% mais rápida do que a GeForce 6600 GT da NVIDIA, 186,99% mais rápida do que a GeForce 6600 da Albatron, 190,05% mais rápida do que a GeForce 6600 da Pixelview, 232,83% mais rápida do que a Radeon X600 Pro, 262,49% mais rápida do que a Radeon X600 XT, e 615,05% mais rápida do que a Radeon X300. A Radeon X850 XT Platinum Edition foi 12,78% mais rápida do que a GeForce 6800 GT da NVIDIA. Na configuração de 1280x1024 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 82,73% mais rápida do que a Radeon X700 Pro, 99,57% mais rápida do que a GeForce 6600 GT da XFX, 100,90% mais rápida do que a GeForce 6600 GT da NVIDIA, 101,13% mais rápida do que a GeForce 6600 GT da Leadtek, 102,48% mais rápida do que a GeForce 6600 GT da Gigabyte, 241,94% mais rápida do que a GeForce 6600 da Albatron, 244,68% mais rápida do que a GeForce 6600 da Pixelview, 264,17% mais rápida do que a Radeon X600 Pro, 278,34% mais rápida do que a Radeon X600 XT, e 671,41% mais rápida do que a Radeon X300. A Radeon X850 XT Platinum Edition foi 31,83% mais rápida do que a GeForce 6800 GT da NVIDIA. Na configuração de 1600x1200 com recursos de aumento de qualidade de imagem, a GeForce 6800 GT da NVIDIA foi 71,36% mais rápida do que a Radeon X700 Pro, 75,58% mais rápida do que a GeForce 6600 GT da XFX, 75,67% mais rápida do que a GeForce 6600 GT da Leadtek, 76,84% mais rápida do que a GeForce 6600 GT da Gigabyte, 77,85% mais rápida do que a GeForce 6600 GT da NVIDIA, 203,45% mais rápida do que a GeForce 6600 da Pixelview, 203,99% mais rápida do que a GeForce 6600 da Albatron, 326,49% mais rápida do que a Radeon X600 Pro, 389,16% mais rápida do que a Radeon X600 XT, e 1.006,13% mais rápida do que a Radeon X300. A Radeon X850 XT Platinum Edition foi 58,15% mais rápida do que a GeForce 6800 GT da NVIDIA. A GeForce 6800 GT é uma excelente placa de vídeo de alto desempenho, oferecendo, em nossa opinião, uma relação custo/benefício muito melhor que a de placas como a GeForce 6800 Ultra e a Radeon X850 XT. Com uma placa dessas você rodará jogos pesados como o Doom 3 e o Far Cry sem problemas, só encontrando problemas nas resoluções muito mais altas (como 1600x1200) ativando todos os recursos de aumento de qualidade de imagem. Resoluções acima de 1280x1024 com todos os recursos de aumento de qualidade do Doom 3 e do Far Cry no máximo é realmente o terreno das placas de vídeo mais rápidas e mais caras do que a GeForce 6800 GT. Pelo preço (bem inferior ao da GeForce 6800 Ultra) e desempenho, estamos dando a ela nosso selo "Produto Recomendado Clube do Hardware". Sinceramente, é a nossa escolha dentro das placas da série 6800 da NVIDIA. Sem contar que você pode ligá-la em modo SLI...

-

Tópico para a discussão do seguinte conteúdo publicado no Clube do Hardware: Como Instalar uma Placa-Mãe "Esse tutorial é um guia passo-a-passo de como instalar corretamente uma placa-mãe." Comentários são bem-vindos. Atenciosamente, Equipe Clube do Hardware https://www.clubedohardware.com.br

-

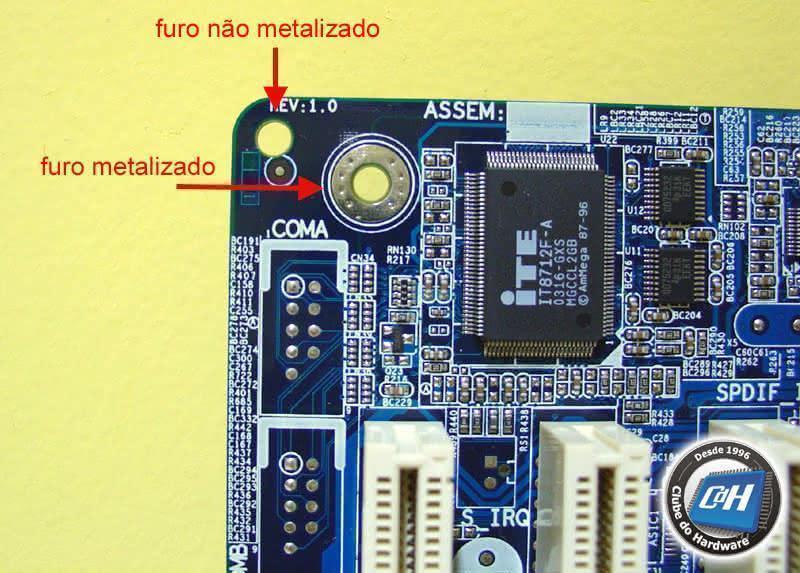

Instalar uma placa-mãe parece ser uma tarefa muito fácil. Acontece que existem alguns macetes envolvidos no processo de montagem que devem ser levados em consideração na hora de instalar uma placa-mãe. Se a sua placa-mãe não for corretamente instalada, você enfrentará sérios problemas de superaquecimento, travamentos e/ou resets aleatórios. Este tutorial é um guia passo-a-passo de como instalar corretamente uma placa-mãe, evitando assim os problemas citados. "Acertando Buracos" A placa-mãe é instalada dentro do gabinete do computador. Por isso, o primeiro passo é abrir o gabinete e localizar a chapa metálica onde a placa-mãe é aparafusada. Normalmente esta chapa pode ser removida desparafusando ela da parte traseira do gabinete e deslizando a mesma em direção à frente do gabinete. Você deve removê-la do gabinete para poder instalar a placa-mãe. Essa chapa possui vários furos, como você pode ver na Figura 1. Figura 1: Chapa metálica onde a placa-mãe será aparafusada. A placa-mãe também possui vários furos, como você pode ver na Figura 2 (utilizamos setas vermelhas para indicar a localização dos furos na placa-mãe). Figura 2: Furos na placa-mãe. Você deve posicionar a placa-mãe sobre a chapa metálica e verificar quais furos da chapa metálica coincidem com os furos da placa-mãe, como mostramos na Figura 3. Como você pode ver comparando as Figuras 1 e 2, a chapa metálica possui mais furos do que são necessários. Em cada furo da chapa metálica que coincidir com um dos furos da placa-mãe você deverá instalar um parafuso de fixação (falaremos mais sobre isso adiante). Já os furos da chapa metálica que não coincidirem com nenhum dos furos da placa-mãe você deve simplesmente deixá-los como estão. Algumas vezes você encontrará furos na placa-mãe que simplesmente não coincidem com nenhum dos furos da chapa metálica. Isto é completamente normal. Você pode ver na Figura 3 que um dos furos da placa-mãe não coincide com nenhum dos furos da chapa. Figura 3: Posicionando a placa-mãe sobre a chapa metálica de modo a coincidir os furos da chapa com os furos da placa-mãe. Junto com o gabinete vem todo o material necessário para a instalação da placa-mãe, como parafusos, parafusos de fixação (que de um lado são parafusos e, de outro, são porcas), arruelas, espaçadores e acabamentos metálicos. Nos furos da chapa metálica que coincidam com os furos existentes na placa-mãe você deverá aparafusar um parafuso de fixação (parafuso-porca). Eles podem ser facilmente instalados girando-os no sentido horário utilizando o seu dedo polegar e o indicador. Figura 4: Parafusos de fixação, parafusos e arruelas que vêm junto com o gabinete. Figura 5: Chapa metálica após a instalação dos parafusos de fixação. Agora você deve posicionar a placa-mãe sobre a chapa metálica novamente e colocar um parafuso em cada um dos parafusos de fixação (parafusos-porca) instalados anteriormente. Porém, existe um detalhe muito importante que muita gente não sabe. Se você prestar atenção nos furos da placa-mãe, você notará dois tipos de furos: metalizados e não-metalizados. Como o nome já sugere, os furos metalizados possuem uma camada metálica ao redor. Preste atenção na Figura 6 para ver a diferença entre esses dois tipos de furo. Figura 6: Diferença entre um furo metalizado e um não-metalizado. Nos furos metalizados você pode utilizar diretamente um parafuso, mas já nos furos não-metalizados você não poderá fazer isso. No caso dos furos não-metalizados, você precisará colocar um isolamento apropriado, de modo a não danificar a placa-mãe. Esse isolamento é feito com a utilização de arruelas de cartolina que acompanham o gabinete. Você deverá colocar duas arruelas de cartolina em cada furo, sendo que uma deverá ficar embaixo do furo e outra acima dele, fazendo um "sanduíche" com o furo da placa-mãe. Um erro bastante comum cometido durante a instalação de uma placa-mãe é utilizar em todos os furos arruelas de cartolina. Isso não deve ser feito. Os furos metalizados foram metalizados para que pudessem ser aterrados com o gabinete.Na verdade, você provavelmente não encontrará nenhum furo não-metalizado em placas-mães vendidas hoje. Caso venha a encontrar, quase sempre não haverá coincidência com nenhum dos furos da chapa metálica do gabinete. Por isso, deixe de lado as arruelas de cartolina que acompanham o gabinete e não as utilize na instalação da placa-mãe. Um outro erro comum e perigoso é utilizar espumas antiestáticas (uma espuma normalmente rosa que vem com a placa-mãe) entre a placa-mãe e a chapa metálica do gabinete. Algumas pessoas acreditam que essa espuma serve para evitar que a placa-mãe entre em contato com a chapa metálica, evitando assim um curto-circuito. Esse pensamento é completamente equivocado. Primeiro, se você instalar corretamente todos os parafusos de fixação e instalar um parafuso em cada um dos furos da placa-mãe, a placa-mãe nunca tocará na chapa metálica do gabinete. Em segundo lugar, a instalação dessa espuma impede a correta dissipação térmica da placa-mãe, fazendo com que o micro apresente funcionamento errático devido ao superaquecimento. O espaço entre a placa-mãe e a chapa metálica é usado para dissipar o calor gerado pela placa-mãe e nada deve utilizado nele. Para mais informações sobre erros cometidos durante a instalação de uma placa-mãe, leia esses dois artigos: Erros típicos de montagem e Gabinetes: Como evitar o superaquecimento. Na Figura 7 você pode ver uma placa-mãe corretamente instalada na chapa metálica do gabinete. Figura 7: Placa-mãe corretamente instalada na chapa metálica do gabinete. Você pode estar pensando agora que o próximo passo é instalar a chapa metálica na parte traseira do gabinete, já que a placa-mãe está devidamente instalada na nela. Mas não é. Antes disso, você precisará fazer algumas coisas. Primeiro, você precisará preparar o gabinete. Se você prestar atenção, o gabinete possui uma abertura retangular medindo 15,87 cm x 4,44 cm para acomodação dos plugues disponíveis na parte traseira da placa-mãe. Essa abertura é tampada com um acabamento metálico que possui pequenos furos que coincidem com os plugues disponíveis na placa-mãe. Você precisa verificar se os plugues da sua placa-mãe coincidem com os furos do acabamento metálico que vem com o gabinete. Veja nas Figuras 8 e 9. Figura 8: Existem vários plugues na parte de trás de uma placa-mãe. Figura 9: Acabamento metálico que veio junto com o nosso gabinete. Em nosso caso, os furos do acabamento metálico do gabinete não coincidiram com os plugues disponíveis em nossa placa-mãe. Por isso, tivemos que remover esse acabamento usando um alicate e substituímos por um acabamento compatível com os plugues da nossa placa-mãe. Placas-mãe geralmente vêm com um acabamento metálico compatível com seus plugues. Já os gabinetes vêm com um acabamento padrão, que nem sempre é compatível com todas as placas-mães. Figura 10: Tivemos que remover o acabamento que veio junto com o gabinete. Figura 11: Acabamento que veio junto com a nossa placa-mãe. Figura 12: Gabinete com o novo acabamento metálico instalado. Agora que você preparou o gabinete, você pode instalar o processador, o cooler do processador e os módulos de memória na placa-mãe. Claro que você pode fazer isso depois, mas instalar estes componentes enquanto a placa-mãe ainda está fora do gabinete é bem mais fácil. Figura 13: Processador, cooler e módulos de memórias instalados na placa-mãe. Coloque a placa-mãe próxima ao local onde ela será instalada no gabinete, como mostrado na Figura 14. Não instale a placa-mãe dentro do gabinete ainda. Antes disto, você terá de instalar todos os fios e cabos do gabinete na placa-mãe. Você pode fazer isso depois, mas instalar esses fios e cabos enquanto a placa-mãe ainda está fora do gabinete é bem mais fácil. Figura 14: Posicionando a placa-mãe para a instalação dos cabos. Localize na sua placa-mãe os conectores do painel frontal (ver Figura 15). Você deverá instalar os fios correspondentes que vêm do painel frontal do gabinete nesses conectores (ver Figura 16). Figura 15: Conectores do painel frontal de uma placa-mãe. Figura 16: Fios do painel frontal do gabinete. Você encontrará os seguintes fios: Chave Reset (não tem polaridade) Chave Power (não tem polaridade), algumas vezes é também chamada de Chave Standby LED Power (tem polaridade), algumas vezes é também chamada de Message LED LED HDD (tem polaridade) Alto-falante (tem polaridade) É só instalar esses fios nos conectores de mesmo nome na placa-mãe. Os fios que possuírem polaridade deverão ser instalados observando a marcação de positivo (+) e negativo (-) presente na placa-mãe. Os fios de cor branca ou preta deverão ser instalados no pólo negativo (-) da placa-mãe. Em algumas placas-mães, os conectores do painel frontal são coloridos, como você pode ver na Figura 15. O problema é que nem sempre as cores dos conectores do painel frontal da placa-mãe correspondem com as cores dos fios do gabinete. Por isso, não siga o esquema de cores na hora de instalar os fios do painel frontal. Figura 17: Fios do painel frontal devidamente instalados na placa-mãe. Se o seu gabinete também possui portas USB e conectores de áudio frontais, leia nossos tutoriais Instalando Portas USB Frontais e Gabinetes com Plugs do Som na Frente. Junto com a placa-mãe vêm alguns conectores externos, como portas USB adicionais, portas FireWire e conectores de áudio (ver Figura 18). Agora você pode instalar estes conectores na placa-mãe, mas não efetuando a sua instalação no gabinete. Você pode fazer isso depois, é claro, mas instalar esses conectores enquanto a placa-mãe ainda está fora do gabinete é bem mais fácil. Figura 18: Conectores externos de uma placa-mãe. Você deve instalar esses conectores seguindo orientações descritas no manual da sua placa-mãe. Nós não podemos explicar aqui onde exatamente esses conectores são instalados, pois a localização dependendo do modelo da placa-mãe. O próximo passo é instalar os cabos do disco rígido, unidades ópticas e de disquete. Se você ainda não instalou esses dispositivos dentro do gabinete essa é uma boa hora. O cabo do disco rígido deve ser instalado na porta IDE1 (primária) e o cabo das unidades ópticas deve ser instalado na porta IDE2 (secundária). O cabo da unidade de disquete deve ser instalado em um conector da placa-mãe chamado “FDD” ou “Floppy”. Para instalar esse cabo, apenas preste atenção no fio vermelho, que o fio indicador de “pino 1”, e que deverá ser instalado de modo que o fio vermelho coincida com a marcação de “pino 1” existente no conector da placa-mãe. Essa marcação é geralmente o número “1” ou “2” impresso em um dos lados do conector (o lado oposto deve ser marcado como “40” ou “39”, ou “33” ou “34” no caso do conector da unidade de disquete). Figura 19: Cabos do disco rígido e das unidades ópticas e de disquete instalados corretamente. O próximo passo é conectar a fonte de alimentação. A fonte de alimentação possui um conector de 20 pinos e sua placa-mãe pode ter um conector extra de 4 pinos chamado ATX12V, que deve também ser instalado (nem todas as placas-mães possuem este conector extra). Você pode precisar levantar sua placa-mãe em um ângulo de 45º em relação à mesa em que você está montando o micro, já que geralmente os fios da fonte de alimentação não são compridos o suficiente para alcançar a placa-mãe enquanto ela está fora do gabinete. Figura 20: Instalando o conector da fonte de alimentação. Figura 21: Instalando o conector ATX12V (apenas se a sua placa-mãe possuir esse conector). O passo final é instalar a placa-mãe dentro do gabinete. Posicione a placa-mãe corretamente (ver Figura 22) e deslize-a na direção da parte traseira do gabinete (ver Figura 23). Feito isso, aparafuse a chapa metálica onde a placa-mãe está instalada na parte de traseira do gabinete. Figura 22: Instalando a placa-mãe no gabinete. Figura 23: Instalando a placa-mãe no gabinete. Agora aparafuse os conectores externos em seus devidos locais no gabinete. Figura 24: Aparafusando os conectores externos. Por último, organize os cabos no interior do gabinete. Veja na Figura 25 como o nosso micro ficou depois que instalamos a placa-mãe. Você pode ver que os cabos ficaram espalhados. Os fios e os cabos devem ser organizados de modo que eles não atrapalhem o fluxo de ar dentro do gabinete ou você poderá ter problemas de superaquecimento. Na Figura 26 você pode ver nosso micro após a organização dos cabos. Figura 25: Nosso micro após a instalação da placa-mãe. Figura 26: Nosso micro após a organização dos cabos. Pronto, sua placa-mãe está agora corretamente instalada e você não terá dores de cabeça. Instale os outros dispositivos que você queira em seu computador e ele estará pronto para a instalação do sistema operacional.

-

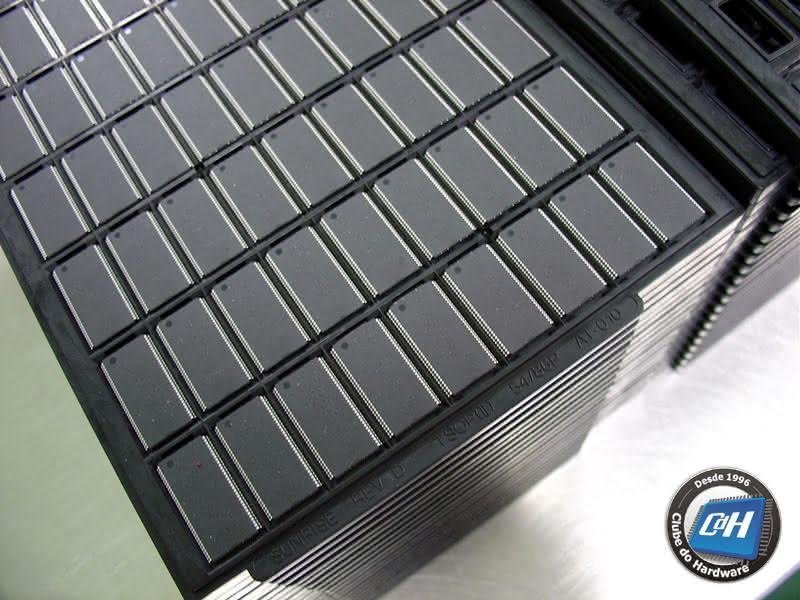

Tivemos a oportunidade de visitar a fábrica da Kingmax em Hsin Chu, Taiwan. Esta é uma grande oportunidade para você aprender sobre como as memórias são fabricadas, já que a Kingmax produz tanto chips quanto módulos de memórias. Estávamos empolgados, pois essa foi a primeira vez que tivemos a oportunidade de ver uma fábrica de chips por dentro. Nas outras fábricas de memórias que visitamos – Kingston, Corsair, OCZ e PDP Systems –, eles fabricam apenas os módulos de memórias. Os chips de memórias chegam a essas fábricas já como um produto final. Existem vários passos envolvidos na fabricação de um módulo de memória: Fabricação do Wafer Fabricação do chip de memória Fabricação da placa de circuito impresso Fabricação do módulo de memória Em resumo, a Kingmax compra o wafer de seus fornecedores (que eles não divulgam quais são), dividem e encapsulam o wafer em chips de memória e depois soldam os chips em módulos de memória. A Kingmax compra a placa de circuito impresso da Brain Power, uma empresa especializada na fabricação de placas de circuito impresso e muito conhecida entre os entusiastas de memórias. A fabricação do chip de memória ou “encapsulamento”, como também é chamada, é feita por uma empresa da Kingmax chamada Kingpak. Após serem fabricados, os chips de memória seguem ainda sem terem sido testados e rotulados (ou UTT, de “UnTesTed”, no jargão da indústria) para a fábrica da Kingmax (que fica situada em um outro local), onde serão testados e rotulados. Após esta etapa, os módulos de memórias são fabricados. A Kingpak também fabrica sensores ópticos para câmeras, e tanto a Kingpak quanto a Kingmax fabricam cartões de memórias. Concentramos nossa visita em descrever como os módulos de memória são fabricados. Como já explicamos, a Kingpak é uma empresa da Kingmax especializada em encapsulamento, ou seja, eles cortam o wafer de memória e adicionam o encapsulamento e pinos à pastilha de silício da memória. Figura 1: Chegada na Kingpak. O processo de encapsulamento das memórias é dividido em dois grandes passos: processo de entrada (mais conhecido como “front-end”) e processo de saída (mais conhecido como “back-end”). Na Figura 2 você pode ver os passos dentro do processo de entrada, enquanto que na Figura 3 você pode ver os passos dentro do processo de saída. Figura 2: Passos do processo de entrada para o encapsulamento das memórias. Figura 3: Passos do processo de saída para o encapsulamento das memórias. O processo de encapsulamento das memórias não é rápido. Para chips de memórias BGA o processo de entrada leva cinco dias, enquanto que o processo de saída leva quatro dias e meio ou cinco dias e meio. Figura 4: Algumas informações do processo de encapsulamento. Na Figura 5 você pode ver um diagrama com a anatomia de um chip de memória. Figura 5: Anatomia de um chip de memória. O encapsulamento é um processo muito delicado. O maquinário e os funcionários trabalham em um ambiente limpo e por isso que não pudemos ter acesso à área de fabricação dos chips de memórias – uma simples partícula de poeira pode acabar com todo o processo -, mas pudemos ver o funcionamento através da janela de vidro existente. Figura 6: Uma visão geral do maquinário utilizado. Figura 7: Aqui podemos ver um funcionário realizando o processo de colocação de fios à pastilha de silício (“wire bond”), veja “Golden Wire” na Figura 5. Figura 8: Essas mulheres estão trabalhando no controle de qualidade. Essas são apenas algumas fases do processo de encapsulamento, já que não tivemos acesso às outras áreas envolvidas na fabricação dos chips de memórias para tirar fotos. Após o término do processo de encapsulamento nessa fábrica, os chips precisam ser rotulados e testados. Ou seja, eles terminam o processo nesta fábrica como chips “UTT” (“UnTesTed”), como os especialistas da indústria de memória chamam chips ainda não testados e não rotulados. Daqui os chips de memória seguem para a fábrica da Kingmax onde serão testados, rotulados e montados em módulos de memórias. Deixamos à fábrica da Kingpak e seguimos para a fábrica da Kingmax. Figura 9: Chegada na fábrica da Kingmax. Após a chegada dos chips na fábrica da Kingmax, eles seguem para as áreas da empresa onde serão rotulados e testados. Figura 10: Como os chips parecem quando chegam na fábrica da Kingmax. Esses chips são chamados “UTT”. Esses chips são colocados dentro de uma máquina de testes, como mostrado na Figura 11. Essa máquina possui várias bandejas, cada uma programada de acordo com a velocidade e temporizações que o fabricante deseja testar os chips. A máquina da Figura 11 possui nove bandejas. Algumas dessas bandejas são utilizadas para armazenar chips de memórias rejeitados. Na Figura 13 você pode entender melhor como esse processo funciona. Na máquina em nossa frente a bandeja 1 estava sendo utilizada para testar memórias DDR433 CL 2.5, a bandeja 2 estava sendo utilizada para testar memórias DDR400 CL 2.5, e assim por diante. As bandejas de seis a nove foram reservadas para os chips rejeitados, que foram separados de acordo com o motivo pelos quais eles foram rejeitados. Figura 11: Máquina para testar os chips de memória. Figura 12: Chips de memória sendo testados. Figura 13: Configuração da máquina para testar os chips de memória. Após a velocidade dos chips de memória tiverem sido definidas e os mesmos testados, os chips são encaminhados para os testes ambientais. Nessa etapa, os chips são colocados em uma grande bandeja que é introduzida em uma espécie de forno onde diferentes condições ambientais são simuladas (isto é, diferentes temperaturas e níveis de umidade) para testar se o chip consegue trabalhar corretamente sob todas as condições ambientais impostas pelo fabricante. Figura 14: Bandeja onde os chips de memórias são instalados para testes ambientais. Figura 15: Máquina para teste de condições ambientais. Figura 16: A mesma máquina em ação. Após a fase de testes, os chips são marcados a laser, ou seja, são rotulados. Aqui o fabricante pode imprimir o que quiser no chip de memória. Na Figura 18 podemos ver o que estava sendo impresso nos chips de memórias dentro da máquina no momento que estávamos visitando a fábrica. Figura 17: Máquina de marcação a laser. Figura 18: Tela da máquina de marcação a laser. Figura 19: Tela do status da máquina. Após essa fase, os chips de memória estão prontos para serem instalados em uma placa de circuito impresso e vendidos como módulos de memória. Nesse ponto, o fabricante de memória tem duas opções: vender os chips de memória para outros fabricantes de módulos de memória ou mandar os chips para sua própria linha de produção de módulos de memória (caso ele possua, como é o caso da Kingmax). A fabricação dos módulos de memória é muito simples: Pasta de solda é adicionada à placa de circuito impresso; Chips de memória e outros componentes (pequenos capacitores e o chip SPD) são colocados na placa de circuito impresso; Os módulos são colocados dentro de um forno onde a solda será derretida, soldando os chips de memória e demais componentes à placa de circuito impresso; Os módulos são retirados do painel; Os módulos de memória são então testados; Os módulos de memória são embalados e enviados para os consumidores. Como falamos anteriormente, a Kingmax compra a placa de circuito impresso (PCB) de uma outra empresa, chamada Brain Power. As placas de circuito impresso vêm em painéis, com vários módulos agrupados (veja na Figura 20). No caso dos módulos que estavam sendo fabricados, cada painel tinha nove módulos. Figura 20: Painéis contendo várias placas de circuito impresso. Figura 21: As placas de circuito impresso da KingMax são fabricadas pela Brain Power. Os painéis com as placas de circuito impresso são removidos das caixas e solda em pasta é aplicada (substância cinza na Figura 22). Um gabarito é utilizado para permitir que a solda seja aplicada apenas nos locais onde o fabricante deseja soldar algo. Figura 22: Solda em pasta sendo aplicada à placa de circuito impresso. Figura 23: Placas de circuito impresso após a aplicação da pasta de solda. Após aplicar a pasta de solda, o painel é colocado na máquina de SMD (Surface Montage Devices, Dispositivos de Montagem em Superfície), processo chamado de “pick-and-place” (“pegar e colocar”), onde os chips de memórias são selecionados pela máquina e posicionados sobre os locais onde serão soldados. Essa máquina também adiciona outros componentes à placa de circuito impresso, como pequenos capacitores e o chip SPD. Figura 24: Máquina SMD. Figura 25: Máquina SMD adicionando componentes aos módulos. Com os componentes adicionados, o painel é colocado em um grande forno onde os componentes são soldados aos módulos. Figura 26: Forno. Figura 27: Módulos entrando no forno. Figura 28: Módulos saindo do forno. Figura 29: Controle de qualidade. Finalmente os módulos são retirados do painel e testados. Primeiro os módulos são testados e, ao mesmo tempo, seus chips SPD são programados. O chip SPD (Serial Presence Detect) armazena todas as informações do módulo de memória, como sua velocidade e temporização. Figura 30: Teste inicial dos módulos de memória e programação do SPD. Após a programação do SPD, os módulos são testados em uma outra estação para certificar que o SPD foi corretamente programado. Figura 31: Verificando os dados do SPD. Após isso, os módulos são enviados para o teste de compatibilidade, que é um gigantesco laboratório com centenas placas-mães de diferentes fabricantes, onde a compatibilidade dos módulos é testada em diferentes plataformas. Figura 32: Teste de compatibilidade. Em seguida os módulos estão prontos para serem embalados, ou seja, os módulos são etiquetados, empacotados e distribuídos para os clientes da Kingmax. Figura 33: Módulos sendo empacotados.

-

Estou indo mais uma vez à Taiwan para participar da Computex, a maior feira de hardware do mundo. Esta é a quarta vez que vou para lá. Desta vez como temos um blog estarei atualizando o blog com o passo-a-passo da minha viagem, porque esta viagem é dose para leão. Só para você ter uma ideia, o meu itinerário dessa vez será Rio de Janeiro - São Paulo - Johanesburgo - Hong Kong - Taipé. De São Paulo até Johanesburgo são mais ou menos 10 horas de viagem e de Johanesburgo até Hong Kong são mais ou menos 13 horas. Só aí já é um dia corrido. Fora o tempo de espera nos aeroportos. São quase dois dias para chegar em Taiwan: saio daqui hoje (sexta-feira) às 14:00 H (horário do Brasil) e minha previsão de chegada em Taipé é domingo 11:25 H (horário local, 11 horas à frente). Tomara que a Internet funcione nos aeroportos, pois caso contrário vou morrer de tédio. Meu vôo está programado para chegar em Johanesburgo as 7 da manhã, com meu vôo para Hong Kong saindo a 1 da tarde. Haja chá de cadeira! Bem, tenho que ir. Continue acompanhando aqui a minha saga... Saindo do Rio, sexta-feira 27 de maio de 2005, 12:00 H Acabei de ligar meu cronômetro. Hora de partida oficial da minha casa: 12:00 H. Antes de ir ao aeroporto, uma passadinha básica na praia aqui perto de casa para tirar uma foto para colocar aqui no blog: Copacabana meio-dia de sexta-feira 27 de maio de 2005. O vôo rumo a São Paulo partiu 14:30 H. Uma foto do Rio, vista aérea rumo a SP: Pão de Açúcar e no lado esquerdo a mesma praia de Copacabana. Sempre que chego a São Paulo de avião me surpreendo com duas coisas, não necessariamente nesta ordem: a poluição e o tamanho da Grande São Paulo, que não pára de crescer. Aliás, tava lendo uma matéria no jornal na semana passada dizendo que o êxodo rural nunca esteve tão forte quanto agora, Rio e São Paulo não param de receber moradores. Haja espaço! Será que o governo não vê que precisa desenvolver as outras regiões para evitar a explosão de vez do Rio e de SP? 17 milhões de pessoas morando na Grande SP é soda... Mas, enfim, isso é papo para muito chopp... Tá, antes que me acusem de bairrismo, do avião também dá para ver um pouquinho de poluição no Rio de Janeiro (já tô vendo que vou receber e-mails dos paulistas dizendo que do avião dá para ver a Linha Vermelha interditada por falsos policiais assaltando carros... ai ai...). O impressionante é que andando por São Paulo não temos ideia de como o ar é poluído, o que vemos na foto abaixo é realmente impressionante. No momento estou no aeroporto de Guarulhos esperando meu vôo para Johanesburgo, África do Sul. Aqui em Guarulhos tem rede wi-fi de graça (ou "na faixa", como dizem os paulistas), da Telefônica, a velocidade é realmente impressionante. Baixei arquivos aqui bem acima de 100 KB/s e rodando um programa para medir a velocidade da rede deu 2 Mbps... Muito bom! A Telefônica está de parabéns. Mas acredito que esta mamata acabe, possivelmente estão testando para oferecer a rede wi-fi de graça somente para quem é assinante Speedy. Aliás, para acessar é necessário preencher um formulário e se você bota um telefone que não seja de São Paulo o sistema reclama que não é área de cobertura deles. Ah, tá, então viajantes não podem acessar a rede? Bem, eu tapeei colocando um telefone qualquer com DDD 11. Deu certo. Fica aí a dica. Continuem acompanhando meu chá de cadeira por aqui. Atualizo o blog quando chegar na África do Sul, tomara que o aeroporto de lá tenha Internet. O chá de cadeira de lá vai ser dose. Meu vôo tá programado para chegar as 7 da manhã e meu vôo para Taiwan parte 1 da tarde. Seis horas de bobeira vendo avião... Johanesburgo, sábado 28 de maio de 2005, 7:00 H (horário local, sexta 2:00 H no Brasil) Johanesburgo foi uma pequena aventura. O comandante acelerou e cheguei 30 minutos antes do horário previsto. Para mim não fez diferença, já que eu ia ter de esperar no aeroporto de qualquer forma. Também preciso corrigir o erro que cometi quando iniciei esta entrada no blog, o tempo de vôo correto de SP a JNB é de 8:30 H. Desenbarcando, a primeira coisa que fiz foi procurar uma conexão com a Internet para atualizar o blog. A conexão do aeroporto não era grátis, mas tinha uns computadores desktop para acessar a rede. Infelizmente neles só dava para acessar o Internet Explorer, então não deu para atualizar o blog, pois ficaria sem acentuação. E ia pegar mal para caramba de puxar o cabo de rede do desktop para meter no meu notebook, quando tinha um monte de gente querendo usar os micros. Eu sei que Brasileiro é meio cara-de-pau, mas não vai ser por mim que vamos ganhar esta fama no exterior. Então, sem nada para fazer e com embarque marcado para 12:30 H rumo à Hong Kong, fui dormir. Até porque eu só havia conseguido dormir uma hora no vôo de São Paulo até a África do Sul, ainda por cima me deu uma dor de barriga e tive que ficar fazendo ponte aérea poltrona-banheiro-poltrona algumas vezes durante a viagem. No aeroporto de Johanesburgo tem um hotel furreca e caro. Nem merece uma estrela. Tudo o que eu queria era tomar um banho quente e capotar até 10:40 H, mais ou menos, pois eu ainda tinha que passar no balcão da Cathay Pacific para pegar o cartão de embarque e ainda tinha uma fila gigantesca para passar pelo raio x, cheio de gente mal-educada furando fila e empurrando (e tem gente que reclama do Brasil e acha que essas coisas só acontecem por aqui). Beleza. Quando tava quase pegando no sono, um indiano maluco começou a bater na minha porta meio desesperado. O cara, que devia ser moreno, tava bege. Ele tinha ficado naquele mesmo quarto antes e tinham roubado US$ 300 da bolsa dele enquanto ele deu uma descidinha para comer algo. Valeu, amigão, mas eu quero é dormir mesmo. A minha desconfiança que este hotel era fuleiro só aumentou depois dessa. Beleza. Quando tava quase pegando no sono mais uma vez, achei que tinha um alien dentro de mim. Depois de remover o bicho, consegui finalmente dormir. Programei o relógio para tocar às 10:40 H. Quando abri o olho novamente, desespero! Já era 12:00 H. O despertador não tocou (tava tão chapado que não conferi se aquele simbolozinho de sino tava ligado ou não). Saí correndo, consegui passar no balcão da Cathay Pacific, passar pelo raio x (que felizmente não tinha mais fila), e pegar o avião. Uma curiosidade que já tinha me chamado a atenção da outra vez que fui à África do Sul e não comentei com ninguém: o plugue da tomada de lá é super esquisito. O que leva um país a querer ser diferente do resto do mundo? Isso me lembra quando eu era pequeno e que todas as tomadas do Brasil eram redondas e para instalar plugue chato "padrão americano" a gente tinha que usar um adaptador ou um "benjamim". Se você reparar na foto, não dá para fazer nenhum tipo de "jeitinho" nessa tomada... Hong Kong, domingo 29 de maio de 2005, 6:30 H (horário local, 17:30 H de sábado no Brasil) Mal sentei na poltrona, correndo e com medo de não pegar o avião, senti que tinha outro alien dentro de mim. O avião já tava andando. E agora? O negócio era me segurar ao máximo. Foi o aviso de apertar cintos se apagar para eu sair correndo e matar de vez este outro alienígena. Ufa, foi por pouco. Ter piriri em avião é brabo. A boa notícia é que eu consegui dormir mais um pouco neste vôo. Pelas minhas contas, minha tabela de sono ficou assim: 1 hora de SP para JNB, 4 horas no hotel fuleiro de JNB, 3 horas no vôo até HKG. Oito horas em dois dias. Brabeira. O pior é aquela situação de não aguentar mais ver filminho (já tinha visto três), não conseguir ler ou usar o computador e não conseguir dormir. Argh. Um conhecido meu uma vez falou que existem dois tipos de pessoas: as que não gostam de andar de avião e as mentirosas. O avião da Cathay Pacific tinha na parede da frente (aquela que dá para os banheiros) uma faixa colorida que ia mudando de cor. Parecia uma luz neon. Pensei: "caramba, já tão fazendo case mod até em avião". Ignora, tava bêbado de sono. Cheguei em Hong Kong sem problemas. O aeroporto de Hong Kong é um dos maiores do mundo. Haja perna. Só para uma comparação grosseira, o que seria andar do extremo do terminal 2 (novo) até o extremo oposto do terminal 1 (antigo) do Galeão no de Hong Kong equivale a andar 10 portões de embarque, somente. Eu desembarquei no portão 72 e meu vôo tava programado para o portão 3. Sem exagero, era 35 minutos andando. Por sorte meu vôo foi cancelado e substituído por outro no mesmo horário no portão 27. Menos mal, precisei andar só 25 minutos. Na foto acima, minha "carruagem" para Taipé. Tive de esperar apenas 1 hora no aeroporto de Hong Kong, como só chegar no portão certo me tomou 25 minutos e ainda tive que ir ao banheiro, beber água, comer uma sopinha chinesa e atualizar rapidinho o blog, não tive de esperar nada. Taipé, domingo 29 de maio de 2005, 11:00 H (horário local, 22:00 H de sábado no Brasil) Finalmente cheguei. Após passar pela imigração e pegar a mala, meia hora. Para chegar ao hotel, mais uma meia hora (o aeroporto de Taipé fica longe da cidade). Cheguei à porta do hotel onde vou ficar exatamente 12:15 H, horário local. Assim temos cronometrado o tempo da porta da minha casa até a porta do hotel em Taiwan: Tempo relativo: 48 horas e 15 minutos Tempo real: 35 horas e 15 minutos Isso que é maratona. Quando falo que leva quase dois dias para chegar em Taiwan tem gente que acha que é exagero meu. Essas fotos acima eu acabei de tirar, são do hotel onde estou no momento (Grand Hotel). Bem, preciso dormir urgentemente, e ainda por cima meu corpo ainda tá pensando que eu estou dentro de um avião. Cheguei são e salvo. A feira começa depois de amanhã (terça-feira), acompanhem a cobertura. A cobertura vai ser coisa séria, ao contrário deste blog, onde me dei a liberdade de falar bobagem.

-

Como Transformar um CD-ROM em CD de Carro

Gabriel Torres respondeu ao tópico de Gabriel Torres em Comentários de artigos

Sim, funciona com DVD-ROM mas não vai tocar discos de DVD porque precisaria de um computador para decodificar o vídeo. Quanto à dúvida da tecla Play, sim é obrigatório ter a tecla Play, pois ela é necessária para iniciar a execução do disco, sem ela o CD não toca. Abraços, Gabriel Torres -

Olá, Seu comentário é completamente infundado. A origem do problema está explicada no artigo. Abraços, Gabriel Torres

-

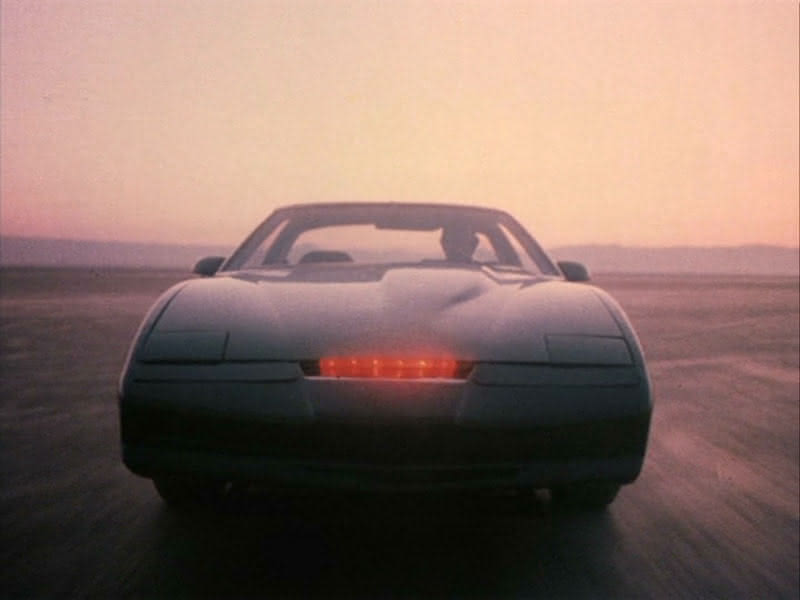

Os meus amigos já sabem que além de fissurado em ruivas vestidas de colegial chupando pirulito vermelho sou fã incondicional de filmes e seriados dos anos 80. Meus filmes prediletos são daqueles ambientados em colégios (Curtindo a Vida Adoidado - um clássico!) onde os nerds se dão bem no final (como Vingança dos Nerds) - deve ser resquício da minha adolescência nerd, quando eu não pegava nem resfriado. Para a sorte de fãs desses filmes grande parte deles foi lançado no Brasil e estão disponíveis em DVD. Toda vez que eu vou aos EUA fico maluco, pois por lá quase todas as séries dos anos 80 estão sendo lançadas em DVD. Eu mesmo já comprei Magnum, Esquadrão Classe A e A Super Máquina e espero ansiosamente que lancem CHiP's! Quando retornei ao Brasil da minha última viagem, surpresa! O box do primeiro ano da série A Super Máquina acabou de ser lançado por aqui! O do Esquadrão Classe A também! E o do Magnum sai agora no final de maio! A Super Máquina era um carro. Um Pontiac Trans Am preto, chamado K.I.T.T. (Knight Industries Two Thousand), com um seqüencial de luzes vermelhas na frente que fazia um barulho típico que na época era a maior sensação (o zunido das luzes do K.I.T.T. está para A Super Máquina assim como o zunido dos sabres de luz está para Guerra nas Estrelas). O que A Super Máquina tem a ver com informática? Tudo. K.I.T.T. era um computador que falava e era capaz de fazer qualquer coisa mirabolante, precursor de minhas tecnologias que hoje existem em carros topo de linha, como GPS com mapa e reconhecimento de voz. Até hoje, quase 25 anos depois da estréia do seriado, o painel da Super Máquina continua sensacional. Uau! Parece o banheiro do Darth Vader! A Super Máquina é a história de Michael Knight (David Hasselhoff -- sim, o mesmo ator de SOS Malibu/Baywatch), um ex-policial jurado de morte e dado como morto que defende os fracos e oprimidos com o seu super carro. A primeira coisa que o Michael Knight falou ao entrar pela primeira vez no carro foi "Uau! Parece o banheiro do Darth Vader!" Não é para menos. David Hasselfhoff antes de correr atrás de peitos siliconados em Malibu. A série esquentou mesmo quando apareceu K.A.R.R. (Knight Automated Roving Robot), que era a Super Máquina "do mal". Igual ao K.I.T.T. só que com luz verde em vez de vermelha. Esses episódios eram dose. Revendo A Super Máquina me deparei com inúmeros "defeitos especiais". Não sei se porque na época a gente não tava ligado, ou se era porque as TVs eram bem menores, mas são erros grotescos. Veja abaixo uma cena onde um ladrão rouba o K.I.T.T. e o carro começa a rodopiar. Repare o volante. Dá para ver que o carro era outro, já que o volante do K.I.T.T. não era redondo. E quando o carro andava sozinho? No episódio piloto ("o longa metragem que deu origem à série" -- lembra disso?) dá para ver claramente como era o truque: havia um camarada alojado atrás do banco do motorista. O buraco do encosto de cabeça era uma janela que permitia a esse cara ver onde ele estava indo (compare o encosto da esquerda, normal, com o da direita, com a janela). O camarada dirigia o carro usando luvas com o mesmo material do estofamento do carro para disfarçar a sua presença. Nos episódios seguintes eles devem ter percebido que dava para ver a trucagem e passaram a filmar o K.I.T.T. andando sozinho em outro plano. Mas a janela da poltrona dá para ver claramente em todos os episódios. Os "defeitos especiais" não diminuem nem um pouco a graça do seriado. Afinal, era os recursos que o pessoal tinha na época para imaginar o que seria uma "Super Máquina", um carro totalmente computadorizado. A temática dos episódios pode parecer boba e até mesmo inocente comparada à violência gratuita que vemos atualmente na TV. De repente aí está justamente toda a graça de A Super Máquina. Acho que falta na TV hoje seriados como esse. PS: os extras que vêm no box são muito bons, com entrevista com os diretores, produtores, David Hasselhoff, etc. Destaque para o "Guia do Usuário" do K.I.T.T., muito legal. O momento queimação de filme (péssimo trocadilho) vai para a inclusão de um DVD extra contendo o filme "Super Máquina 2000", que é muito podre. Rodado para TV em 1991, Michael Knight acha as peças do K.I.T.T. em um galpão e resolve montar o computador em um Chevrolet da década de 1950 azul água. Muito tosco ver uma banheira dessas com as luzes do K.I.T.T. Ainda por cima um dos vilões é interpretado por Mitch Pilleggi, o Walter Skinner de Arquivo X. Para um fã de Arquivo X como eu é dureza ver Pileggi em um papel tão ruim.

-