-

Posts

8.858 -

Cadastrado em

-

Última visita

Tipo de conteúdo

Artigos

Selos

Livros

Cursos

Análises

Fórum

Tudo que Gabriel Torres postou

-

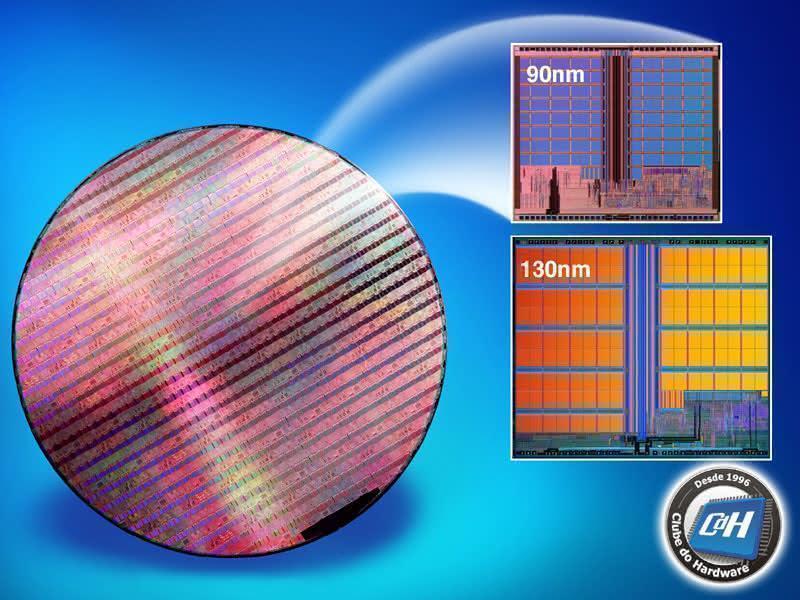

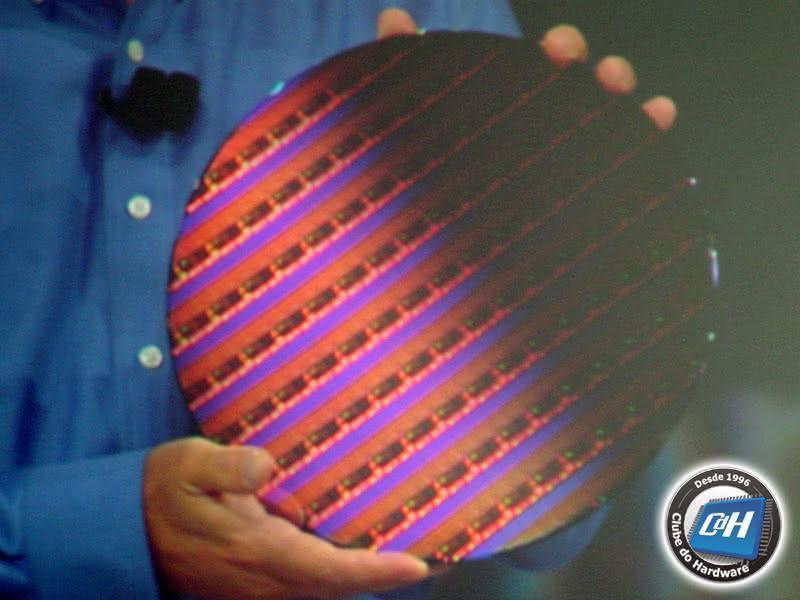

Há exatamente um ano, no IDF Fall 2003, Paul Ottelini apresentou um wafer de 300 mm contendo pastilhas de silício de 65 nm. Na abertura deste IDF ele mostrou novamente o mesmo wafer. Desta vez, no entanto, Mark Bohr, do departamento de tecnologia lógica da Intel, explicou de forma aprofundada detalhes sobre esta tecnologia, que, de acordo com os planos da Intel, deverá estar equipando novos processadores a partir de 2005 ou 2006. Figura 1: Paul Ottelini apresenta wafer de 300 mm contendo pastilhas de silício de 65 nm na abertura do IDF Fall 2004. Os processadores atuais da Intel são fabricados no processo de 90 nm ou 130 nm. Diminuir o processo para 65 nm permite ao processador permite uma maior densidade de transistores, isto é, uma maior quantidade de transistores por milímetro quadrado. Para você ter uma ideia, com esta tecnologia é possível construir 10 milhões de transistores de memória estática – usada no circuito de memória cache – em apenas 1 mm quadrado (o tamanho da ponta de uma caneta esferográfica). O processo de 65 nm da Intel usa interconexões de cobre em oito camadas (o processo de 90 nm usa interconexões de sete camadas), como você pode ver na Figura 2. Figura 2: Tecnologia de 65 nm da Intel. O tamanho reduzido cria uma série de desafios. Para você entender melhor, os circuitos integrados são fabricados usando um processo chamado fotolitografia. Este processo consiste em basicamente marcar o silício usando uma luz de um determinado comprimento de onda. O problema é que para processos abaixo de 250 nm o comprimento de onda dessa luz é menor que o tamanho da área a ser gravada, como você pode ver na Figura 2. No processo de 65 nm a luz usada na gravação tem um comprimento de onda de 193 nm, o que representa uma grande diferença. Figura 3: Comparação do comprimento de onda usado no processo de fotolitografia. A solução usada pela Intel para resolver este problema foi a criação máscaras com alternação de mudança de fase, como mostra a Figura 4. Figura 4: Comparação do comprimento de onda usado no processo de fotolitografia.

-

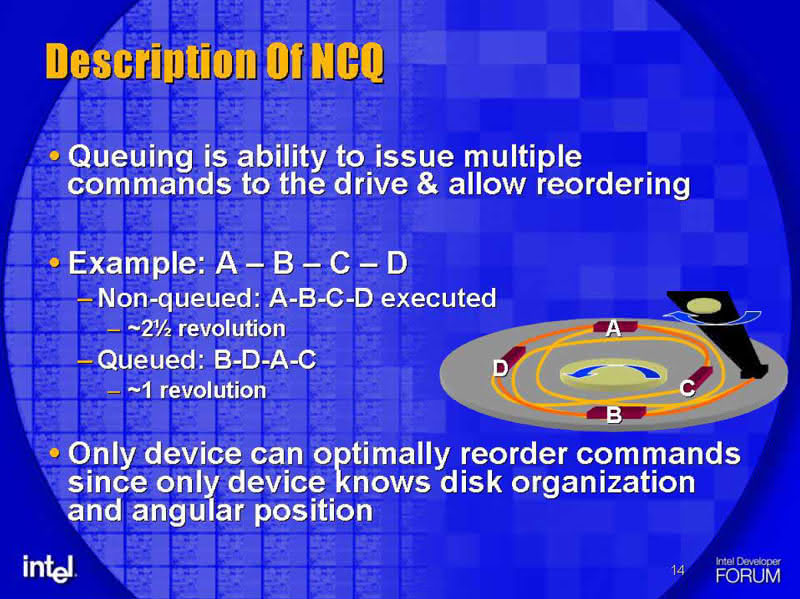

Em nosso segundo dia no IDF nós participamos de um laboratório para testarmos na prática o novo recurso presente na especificação Serial ATA II, chamado NCQ (Native Command Queuing). Nós já havíamos aprendido sobre este recurso no IDF Spring 2003, ou seja, há um ano e meio atrás, mas não tínhamos ainda o visto na prática. Este recurso aumenta o desempenho do disco rígido quando uma série de comandos de leitura de pontos distantes um do outro é enviada pelo computador. O disco rígido pega esses comandos e os reordena, de forma que ele consiga ler o máximo de dados do disco rígido com apenas uma rotação do disco. Veja na Figura 1. O computador pediu para o disco ler as posições A, B, C e D. Sem este recurso, o disco levará 2 voltas e meia para ler todos os dados pedidos (linha amarela). Já com a reordenação, o disco irá modificar a ordem para B, D, A e C, levando apenas uma volta para ler todos os dados pedidos (linha laranja). Figura 1: Funcionamento do NCQ. A Intel colocou à nossa disposição um micro com um disco rígido Serial ATA com este recurso (Seagate ST3160023AS, de 160 GB). A configuração do micro era: Pentium 4 3,2 GHz, 1 GB de memória RAM, placa de vídeo GeForce 6800 e placa-mãe Intel. Rodamos dois programas, o PCMark04 e o IOMeter em duas situações, com o NCQ desabilitado e com este recurso ativado. Os resultados que obtivemos no PCMark04 foram os seguintes: o uso do disco rígido (HDD Usage) aumentou de 5.978 MB/s para 6.112 MB/s, um aumento de apenas 2,24%; já o desempenho do carregamento do Windows XP (XP startup) aumentou 9,76%, pulando de 8.947 MB/s para 9.821 MB/s. Já com o IOMeter, sem o NCQ o desempenho foi de 119, pulando para 142 com este recurso ativado, ou seja, um aumento de 19,32% no desempenho de disco da máquina. Nada mal. A diferença de desempenho entre o IOMeter e o PCMark04 é facilmente explicada. O recurso NCQ só aumenta o desempenho quando o disco recebe uma série de comandos fora de ordem. No caso do PCMark04, o mais provável é que o seu teste de leitura do disco (HDD Usage) seja seqüencial, enquanto que o IOMeter faz leituras aleatórias de áreas do disco, daí o melhor resultado neste programa. Além disso, o carregamento do Windows XP – que necessita a leitura de vários arquivos espalhados pelo disco – melhorou consideravelmente, de acordo com o PCMark04. Uma novidade que a Intel deixou escapar durante a sua apresentação sobre memórias DDR2 é o lançamento, até o final deste ano, de um processador Pentium 4 de 3,46 GHz com 2 MB de memória cache L2 e com barramento externo de 1.066 MHz. Ainda não temos detalhes sobre este novo barramento, mas o valor sugere que seja um barramento de 266 MHz transferindo quatro dados por pulso de clock. A Intel mostrou uma comparação deste novo processador usando memória DDR2-533 com um Pentium 4 Extreme Edition de 3,4 GHz, que também tem memória cache L2 de 2 MB, usando memórias DDR400 e placa-mãe com chipset Intel 875P. Os resultados você confere na Figura 2: o novo processador foi 5% mais rápido no SPECint_base2000, que mede desempenho de processamento usando números inteiros, e 11% mais rápido no SPECint_fp2000, que mede o desempenho da unidade de ponto flutuante ("co-processador matemático"). O uso da memória DDR2-533 e do novo barramento de 1066 MHz foram os responsáveis por este incremento no desempenho, já que ambos rodam praticamente na mesma freqüência. Importante notar que estes valores são estimativas preliminares, já que este processador ainda não existe. Figura 2: Estimativa de desempenho para o novo Pentium 4 Extreme Edition de 3,46 GHz com barramento de 1.066 MHz. Neste IDF a Intel voltou a enfatizar a grande característica da memória DDR2, que é o seu consumo, na ordem de 30% menor que o das memórias DDR266 e na ordem de 40% menor que o das memórias DDR333, o que torna esta memória perfeita para notebooks – além de oferecer um desempenho maior que as memórias DDR. Segundo a Intel, o uso de memórias DDR2 pode representar até 10% de ganho na duração da bateria do notebook. Figura 3: Consumo das memórias DDR2. A Intel aproveitou para nos atualizar sobre o desenvolvimento das memórias DDR2-667 e DDR2-800. O padrão DDR2-667 está na sua fase final de especificação, enquanto o padrão DDR2-800 está em sua fase inicial de especificação. Para que você entenda melhor o que isto quer dizer, a criação de um novo tipo de memória passa por sete estágios. A fase em que o padrão DDR2-667 está hoje é a quarta (ou seja, faltam ainda três etapas para chegar ao mercado) e a fase em que o padrão DDR2-800 está é a segunda (ou seja, faltam ainda cinco etapas até que ela chegue ao mercado). Figura 4: Etapas onde o desenvolvimento das memórias DDR2-667 e DDR2-800 estão hoje. Durante este IDF a Intel apresentou mais detalhes sobre as futuras memórias DDR3, que deverão chegar ao mercado somente em 2006. Como você pode ver na Figura 5, os primeiros modelos serão de 800 MHz e 1066 MHz. Lembrando que, como ocorre com as memórias DDR e DDR2 este clock é "falso" pois indica o desempenho da memória e não o seu clock real. Figura 5: Planejamento da Intel para memórias. Segundo a Intel, as memórias DDR3 terão uma latência de 15% a 20% menor do que as memórias DDR2, serão alimentadas com 1,5 V e usarão um conector com a mesma quantidade de pinos dos módulos DDR2, porém com travas de instalação posicionadas em locais diferentes – isto é, não será possível instalar módulos DDR3 em soquetes DDR2 e vice-versa. O grande problema das memórias DDR3 é que só podemos instalar apenas um módulo por canal. As memórias DDR2 nós podemos instalar dois módulos por canal e no caso das memórias DDR convencionais é possível o uso de até três módulos por canal. Esta limitação física impede a criação de placas-mães com mais de um soquete (no caso de DDR3 single channel) ou com mais de dois soquetes (no caso de DDR3 dual channel), o que realmente é um problema. A solução para isto é o uso da nova tecnologia FB-DIMM (Fully Buffered DIMM), que a Intel já havia apresentado no IDF passado. Com o uso de módulos FB-DIMM, a capacidade de instalação de memória pula para oito módulos por canal. Sugerimos que você leia a nossa cobertura do IDF Spring 2004 para entender mais detalhadamente como esta tecnologia funciona.

-

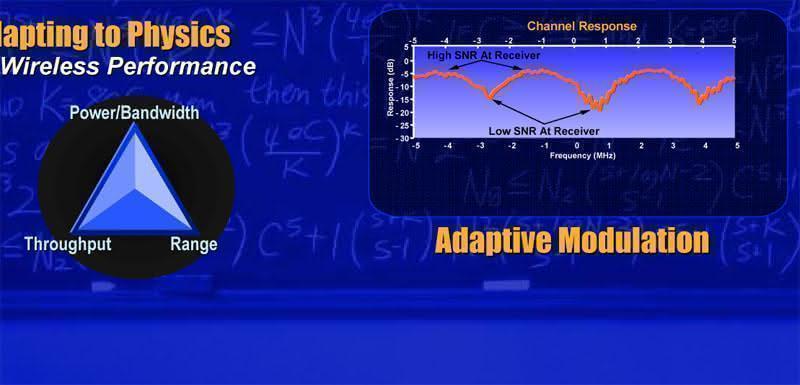

Esta edição do IDF, Intel Developer Forum, foi novamente realizada em San Francisco, Califórnia, desta vez no Moscone Center North. Este evento é um dos mais importantes da indústria de PCs; nele a Intel e empresas parceiras mostram as tecnologias que estão desenvolvendo, que podem demorar anos até chegar ao mercado. Trata-se, portanto, de uma oportunidade única de ver o que há de mais novo em termos de pesquisa e desenvolvimento de hardware, muito antes dos produtos que usam as tecnologias apresentadas entrarem no mercado. O evento foi mais uma vez aberto por Pat Gelsinger, vice-presidente sênior e executivo-chefe de tecnologia (CTO, Chief Technology Officer), que explicou o que é o IDF, sua importância e a sua programação, e aproveitou para oficialmente confirmar a entrada do Brasil no circuito oficial do IDF: teremos um IDF em São Paulo no dia 17 de novembro de 2004. Será um evento menor, já que o IDF dos EUA tem três dias de duração. Figura 1: Pat Gelsinger abrindo o IDF Fall 2004, em San Francisco. Figura 2: Brasil finalmente entra no mapa do IDF! Em seguida, Paul Otellini, presidente e executivo-chefe de operações (COO, Chief Operating Officer) subiu ao palco para falar sobre a visão da Intel para os próximos anos e o que podemos esperar de novos produtos da Intel para os próximos seis meses. Otellini foi rápido e rasteiro: a Intel está apostando em duas tecnologias para o futuro próximo. Primeiro, processadores com mais de um núcleo, que começarão a ser realidade já este ano, com o lançamento do Montecito, nome-código do processador Itanium de núcleo duplo. E, segundo, a tecnologia Wi-Max (IEEE 802.16), de rede metropolitana sem fio. Figura 3: Paul Otellini apresenta amostra do Itanium de núcleo duplo (Montecito). Ter mais de um núcleo significa que o processador na realidade tem dois ou mais processadores dentro dele, podendo realizar tarefas em paralelo, da mesma forma que ocorre atualmente com computadores que possuem mais de um processador na placa-mãe. Há várias vantagens em se colocar mais de um processador diretamente dentro do próprio processador, como a velocidade de comunicação entre os núcleos (em um sistema multiprocessado tradicional os processadores comunicam-se através da placa-mãe, que não proporciona a maior velocidade de comunicação possível entre eles) e um menor custo. A previsão da Intel é que processadores com mais de um núcleo estarão mais presentes em 2006, com uma fatia de mercado maior que 40% no mercado de desktops de alto desempenho, maior que 85% no mercado de servidores e maior que 70% no mercado de notebooks de alto desempenho. Figura 4: Previsão da Intel para os processadores com mais de um núcleo. A Intel apresentou um protótipo de servidor com quatro processadores de núcleo duplo. O Windows reconheceu a presença de 16 processadores: cada processador tem dois núcleos e cada núcleo usa a tecnologia Hyper-Threading – que faz o sistema reconhecer cada núcleo como sendo dois processadores, daí o Windows reconhecer cada processador de núcleo duplo como sendo quatro processadores. A NASA, agência aeroespacial norte-americana, participou desta apresentação, anunciando o projeto Columbia, um supercomputador que usará aproximadamente 10.000 processadores Itanium 2 e, quando estiver pronto, será o supercomputador mais rápido do mundo (desde que até lá ninguém lance outro supercomputador mais rápido), com aproximadamente 60 TeraFLOPs de capacidade de processamento. A Intel está apostando nas seguintes novas tecnologias para os seus próximos processadores: Hyper-Threading, que hoje equipa 55% dos processadores Intel para desktops e 100% dos processadores Intel para servidores; EM64T, a tecnologia de 64 bits da Intel, lançada no IDF passado; LaGrande, que protege o PC contra a ação de hackers e que foi apresentada no IDF Fall 2003; Vanderpool, tecnologia que permite "dividir" o PC em várias máquinas e que também foi apresentada no IDF Fall 2003; e a tecnologia iAMT, Intel Advanced Management Technology, que terá suas especificações publicadas no próximo IDF. As tecnologias LaGrande e Vanderpool (tecnologia de virtualização) serão possíveis com o próximo sistema operacional da Microsoft, o Longhorn. Paul Otellini mostrou razões bem convincentes porque a Intel está apostando tanto na tecnologia Wi-Max, que permitirá redes sem fio metropolitanas, isto é, uma única antena atenderá a uma área muito maior do que a tecnologia Wi-Fi (IEEE 802.11), podendo cobrir um bairro inteiro. Em 2003 somente 10% dos notebooks vinham de fábrica com antena para redes sem-fio. A previsão para 2004 é que esse número aumente para 60% e chegue a até 96% em 2006. Figura 5: Previsão do IDC para o mercado de notebooks com rede wireless. Em 2000, 90% das conexões à Internet eram feitas por linha discada e somente 10% por banda larga. A previsão para 2004 é que o número de usuários de banda larga praticamente iguale o de conexão discada, nos EUA, com a conexão wireless representando 8% das conexões. Já a previsão para 2008 é que apenas 22% das conexões sejam discadas, com 40% dos usuários fazendo conexão via Wi-Fi e 8% via Wi-Max. Figura 6: Previsão da Intel para métodos de conexão. A Intel prevê ainda que teremos em 2006 os primeiros notebooks vindo com rede Wi-Max de fábrica, atingindo um número expressivo de unidades em 2008. Figura 7: Previsão da Intel para o mercado de notebooks. Isto posto, Otellini apresentou o primeiro sistema Wi-Max em um único chip da Intel. Figura 8: Paul Otellini apresenta a placa de desenvolvimento do primeiro sistema Wi-Max em um único chip da Intel. A NVIDIA aproveitou o IDF para fazer uma apresentação explicando suas tecnologias atuais, a maioria delas já abordamos na nossa cobertura do lançamento do GeForce 6800, como o modelo Shader 3.0, então não vamos repeti-las aqui. A NVIDIA mostrou o seu módulo MXM, que já falamos aqui, e as tecnologias SLI (Scalable Link Interface) e SDI (Serial Digital Interface). A tecnologia SLI é uma conexão entre placas de vídeo que permite que os processadores gráficos trabalhem em paralelo, similar ao que ocorre em computadores multiprocessados. A NVIDIA mostrou um demo do simulador de vôo Aechelon, que é um simulador profissional, usado pelas forças armadas. Pudemos comprovar o aumento de desempenho: uma placa Quadro FX 3400 produzia 30 quadros por segundo e, colocada juntamente com outra placa ligada via SLI, o desempenho dobrou, pulando para 60 quadros por segundo. O ponto forte é que não a necessidade de qualquer modificação no software para o funcionamento desta tecnologia. Figura 9: Tecnologia SLI da NVIDIA. Figura 10: Com o uso de duas placas de vídeo o desempenho dobrou. Já a tecnologia SDI é voltada para aplicações profissionais de vídeo, tais como estúdios de TV e vídeo. Trata-se de uma interface de vídeo profissional. Outra aplicação cogitada pela NVIDIA é o de cinemas digitais. O distribuidor de filmes, em vez de fazer cópias físicas da película, transmitiria via satélite o filme, em tempo real, para o cinema, que então projetaria o filme, usando um computador equipado com esta interface. Esta transmissão seria obviamente criptografada. Figura 11: Placa Quadro FX 4000 com interface SDI. Figura 12: Arquitetura da placa Quadro FX 4000 com SDI. A NVIDIA apresentou ainda alguns demos das tecnologias de correção de imagem presente nos processadores GeForce da série 6. Estes processadores de vídeo são na realidade "dois em um": além do chip gráfico em si, há integrado ao próprio chip um processador de imagens, para a decodificação de vídeo. Como pudemos comprovar ao vivo, este recurso permite imagens sem aqueles "quadrados" quando aumentamos a janela de reprodução do vídeo, além de fazer com que não haja pausas durante a reprodução de vídeo, o que é muito comum de ocorrer especialmente se o processador da máquina não é tão rápido. Ou seja, em micros com placas de vídeo usando os chips da série GeForce 6 a decodificação de vídeo passa a ser papel da placa de vídeo, e não mais do processador do micro. Para mais informações, leia a nossa cobertura do lançamento do chip GeForce 6800.

-

Olá, O preço tanto de livros quanto de programas é determinado pela editora. O autor ganha royalties (comissão sobre vendas). Não acho o preço dos livros caro no Brasil; ele está no mesmo patamar do preço em outros mercados. Acho que o problema é outro: o brasileiro é que ganha pouco. Sinceramente, acho que em vez do pessoal reclamar do preço das coisas, deveria lutar para uma maior valorização profissional, salarial, de remuneração, etc. Abraços, Gabriel Torres

-

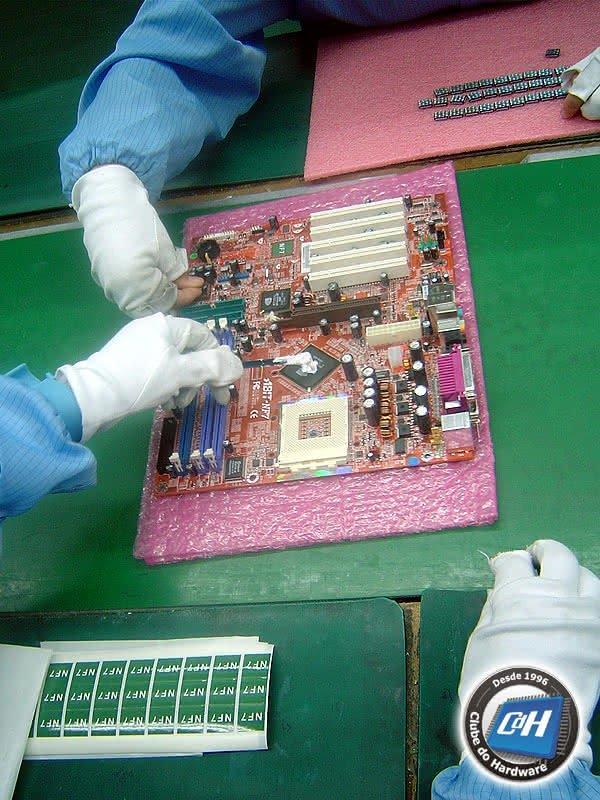

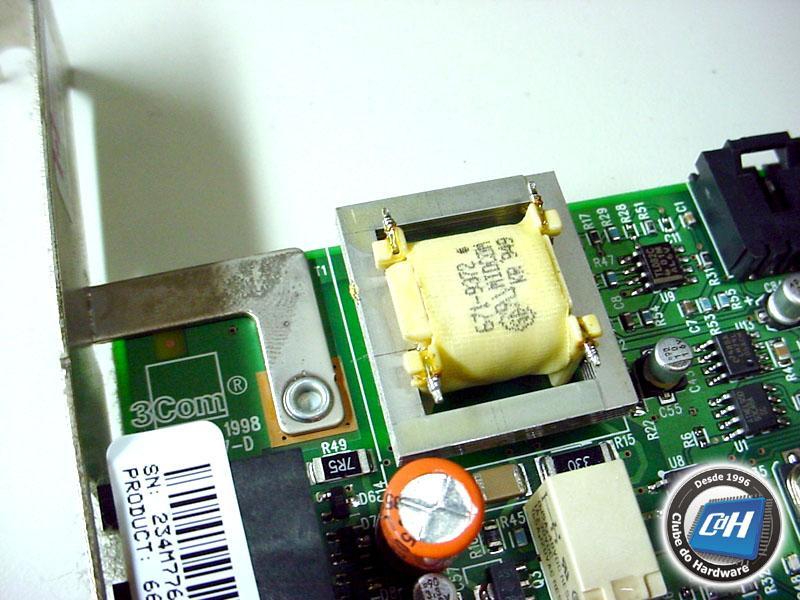

A ABIT organizou um campeonato mundial de LAN Party, chamado ACON4, em 21 países diferentes. Os vencedores de cada país foram convidados a disputar a final em Xangai, China Continental, com todas as despesas pagas pela ABIT. O jogo era o WarCraft III e as máquinas foram montadas com placas-mães ABIT AG8 (soquete LGA775), placas de vídeo ATI Radeon X800, processadores Pentium 4 de 3,6 GHz soquete LGA775, memórias Kingston DDR500, discos rígidos Western Digital 74 G Raptor Serial ATA de 10.000 rpm, gabinetes Coolermaster, monitores Viewsonic LCD de 17" e mouses Logitech. O ganhador levou um carro da Kia, o segundo lugar ficou com US$ 3.500, o terceiro lugar levou US$ 2.000 e o quarto lugar colocou US$ 1.000 no bolso. Nós fomos convidados a assistir a esta disputa final (o ganhador foi o concorrente norte-americano e, em segundo lugar, ficou o concorrente russo – que ironia!) e aproveitar nossa ida até Xangai para visitar a fábrica da ABIT e também a fábrica das memórias Kingston. Figura 1: China, país generoso. Figura 2: Final do campeonato ACON4, em Xangai, China. Uma curiosidade deste campeonato é que fiscais do governo chinês fiscalizaram cada passo do campeonato. Para você ter uma ideia, o lugar onde cada finalista ficaria sentado teve de ser aprovado pelos representantes do governo antes do início do campeonato, e os fiscais verificavam o tempo todo se as pessoas estavam sentadas nos locais previamente acordados. Ficava parecendo que qualquer saída milimétrica do acordo estabelecido entre a ABIT e o governo chinês seria motivo para encerrar o campeonato e mandar todo mundo de volta para casa. Não muito diferente do Brasil durante o governo militar. Se você reparar com atenção a Figura 2 você verá os fiscais em ação atrás dos competidores. Na Figura 3 você os vê sentados após o término do campeonato. Figura 3: Fiscais do governo chinês. Visitar a China é sempre uma aventura. Por conta dos problemas políticos entre a China e Taiwan, na há vôos diretos entre Taiwan e a China Continental. Por isso, tivemos que ir de Taiwan até Macau e de Macau até Xangai. Macau é uma ex-colônia portuguesa que foi devolvida a China em 1999, e que fica a uma hora de barco de Hong Kong. Macau, assim como Hong Kong, é uma Zona Administrativa Especial, fazendo parte do que os chineses chamam de "um país, dois sistemas", já que Macau e Hong Kong tem sua própria moeda. O que achamos engraçado é que em Macau, apesar de ter sido colonizado por Portugal, a direção é inglesa, como Hong Kong, e não convencional, como o resto do mundo incluindo a própria China. A vôo de Taipé até Macau demora 1:30 H, e de Macau até Xangai leva outra 1:30 H. Por conta da espera em Macau pelo próximo vôo e deslocamento, são gastos quase 6 H. Isto sem contar o que já havíamos passado para chegar em Taiwan (uma hora entre Rio e São Paulo, cinco horas de espera em São Paulo, oito horas de vôo até a África do Sul, cinco horas de espera na África do Sul, 13 horas de vôo entre a África do Sul e Hong Kong, uma hora de espera em Hong Kong e mais uma hora e meia de vôo entre Hong Kong e Taipé – são literalmente dois dias voando e, acredite, este é o caminho mais rápido). Xangai é uma cidade com 16 milhões de pessoas – ou seja, quase do tamanho de São Paulo. São enormes arranha-céus para todos os lados e, ao mesmo tempo, várias casas e prédios ao estilo oriental. É o contraste que faz de Xangai uma cidade única. Figura 4: Xangai a noite. Figura 5: Enorme templo budista ao lado de um arranha-céu. Cena comum em Xangai. Este é o Templo do Buda de Jade. A fábrica da ABIT, que é chamada Rolly, fica na cidade de SuZhou (pronuncia-se "su-tjou"), aproximadamente a 100 Km a leste de Xangai. SuZhou é uma cidade pequena para os padrões chineses, com 1 milhão de habitantes e sua principal atração são os seus jardins, mais de 2.000 espalhados pela cidade. Devido a problemas políticos entre Taiwan e China, a fábrica da ABIT não pode se chamar ABIT. Por isso, seu nome oficial é Rolly. Construída em 1999, esta fábrica é responsável pela fabricação de todos os produtos da ABIT. Antes de sua construção os produtos eram fabricados em uma fábrica que a ABIT tinha em Taiwan, sendo que esta fábrica em Taiwan não existe mais. Eles também fabricam produtos para outras empresas, como Canon e Yamaha – mas nunca para outras empresas de placas-mães. Figura 6: Missão da Rolly, fábrica da ABIT em SuZhou. A ABIT mantém um centro de pesquisa e desenvolvimento na Rolly, onde alguns dos produtos da ABIT são desenvolvidos. Figura 7: Centro de Pesquisa e Desenvolvimento da ABIT dentro da Rolly. Figura 8: Centro de Pesquisa e Desenvolvimento da ABIT dentro da Rolly. Vamos dar uma rápida olhada nas linhas de produção da ABIT antes de falarmos o que vimos de diferente na ABIT para as outras fábricas que já visitamos. O processo de fabricação de uma placa-mãe ou uma placa de vídeo é praticamente o mesmo em todas as fábricas. A placa de circuito impresso (PCB) chega e nela é aplicada uma pasta de solda nos pontos onde componentes SMD serão instalados. A placa segue por uma esteira para a linha de inserção SMT (SMD e SMT são praticamente sinônimos; enquanto SMD refere-se ao componente, SMT refere-se à tecnologia de soldagem). Nesta linha robôs pegam e instalam os componentes SMD em seus locais apropriados. Após a inserção de todos os componentes SMD, a placa segue pela esteira para um forno de solda, onde a pasta aplicada na primeira etapa derrete e solda os componentes. Ao final e em pontos durante o processo que o fabricante julgar necessário, funcionários (normalmente mulheres) inspecionam visualmente a placa a procura de erros. Figura 9: Visão geral das linhas SMD da ABIT. Figura 10: Uma das placas-mães que estavam sendo fabricadas durante nossa visita. No caso da ABIT, após o término da linha SMD, uma máquina faz o controle de qualidade visual. Não são todas as fábricas que dispõem deste aparelho. Esta máquina é programada para inspecionar, visualmente, determinados pontos da placa-mãe. Caso o ponto não esteja bem soldado, por exemplo, a máquina acusa e a placa é encaminhada para uma das funcionárias para a correção de erros. Normalmente em linhas de produção são usadas mulheres, pois já foi comprovado em pesquisas que mulheres acham erros com mais facilidade do que os homens. Além da inspeção visual por máquina, a inspeção manual por uma funcionária continua existindo. Figura 11: Controle de qualidade visual. Após o término do controle de qualidade da linha SMD, a placa segue para a linha de inserção manual, também chamada DIP. Nesta linha são inseridos os componentes maiores, que requerem solda convencional, como soquetes, conectores, capacitores eletrolíticos, slots, etc. A placa segue em uma esteira que corre em frente a vários funcionários. Cada funcionário é responsável pela inserção de um componente. A placa segue pela linha até que todos os componentes sejam inseridos. Em seguida, a placa segue para o seu banho de solda, onde ela entra em uma máquina soldadora automática onde o seu lado da solda é banhado por solda e os componentes saem da máquina automaticamente soldados. Em seguida, a equipe do controle de qualidade entra em ação conferindo se todas as soldas ficaram perfeitas ou não. Em seguida, funcionários instalam o BIOS, a bateria e o dissipador de calor do chipset, e eventualmente outros componentes que não podem ser instalados antes da máquina de solda. Por fim, Após esta etapa, a placa está pronta para uso. Figura 12: Detalhe de uma das linhas de inserção manual da ABIT. Figura 13: Funcionária programando os chips do BIOS. Este processo ocorre em outra área. Figura 14: Funcionários instalando o chip do BIOS e aplicando a pasta térmica sobre o chipset. Estando a placa fabricada, a próxima etapa é o seu teste funcional, naturalmente. Neste teste, a placa-mãe é ligada e todos os seus componentes são testados. Este é um teste obrigatório e todas as placas são testadas. Figura 15: Baias onde as placas recém fabricadas são testadas uma a uma. O que ocorre após o teste funcional da placa varia de fabricante para fabricante. Vale a pena explicarmos melhor o que ocorre na ABIT. Nós já visitamos várias fábricas de placas-mães, incluindo as fábricas da MSI, da Gigabyte e da ECS/PCChips, só para citarmos as mais importantes. De uma forma geral, todas as fábricas são iguais, já que o processo de produção é basicamente o mesmo. O que pode eventualmente variar de acordo com o fabricante é a quantidade de pontos onde as inspeções visuais são feitas durante o processo de fabricação. O que a ABIT tem de realmente diferente para os outros fabricantes é a quantidade de testes efetuados ao longo do processo de fabricação. Normalmente os fabricantes fazem somente um teste funcional (verificam se a placa liga e rodam um programa de teste de hardware para testar todos os recursos da placa-mãe) e, eventualmente, um burn-in (deixam a placa-mãe ligada 24 horas). Por conta da demora no teste de burn-in, muitos fabricantes simplesmente não fazem mais este teste e aqueles que ainda o fazem efetuam o teste por amostragem, isto é, apenas algumas placas-mães são aleatoriamente escolhidas para serem testadas. Aliás, só vimos uma fábrica de placas-mães onde todas as placas passavam por burn-in e foi no Brasil (na Netgate, mas isso foi em outubro de 2000 e pode ser que o procedimento tenha sido alterado). Mas é claro que em uma fábrica que produz 3.000 placas-mães por mês isto é fácil de ser feito. Em uma fábrica que produz quase 1 milhão de placas por mês, isto torna-se quase impossível. Então, na maioria das fábricas é assim que funciona: após o teste funcional algumas placas são sorteadas para ficarem em burn-in por 24 horas e o restante é imediatamente embalado. E c'est fini. Dentro do processo da ABIT, entretanto, são efetuados seis testes após o teste funcional: compatibilidade, burn-in, ambiental, confiabilidade, vibração e queda. Estes testes são realizados por amostragem, isto é, somente algumas placas são testadas. Segundo eles, isto é suficiente para descobrirem eventuais falhas no processo de fabricação. Realmente nunca vimos uma fábrica com tantos testes. No teste de compatibilidade, a ABIT testa 10 peças de cada modelo sendo fabricado por dia para ver como se comporta a compatibilidade do produto com vários sistemas operacionais e com peças de vários fabricantes (por exemplo, vários modelos de memórias de vários fabricantes), a fim de descobrir se existe algum conflito ou incompatibilidade com o produto que está sendo testado. Figura 16: Laboratório onde o teste de compatibilidade é executado. O teste de burn-in da ABIT é por amostragem, testando 10 peças de cada modelo que está sendo fabricado por dia, rodando o Windows XP e rodando vários programas de testes na temperatura ambiente por 24 horas para ver se nenhum problema ocorre. Figura 17: Teste de burn-in em execução. Já o teste que a ABIT chama de ambiental é algo que nunca vimos em nenhuma outra fábrica (ou, se existe nas outras fábricas que visitamos, não nos mostraram). Neste teste, a peça testada é colocada em funcionamento em uma câmara térmica que parece um forno gigante. Nesta câmara, a temperatura é baixada a 0 grau e depois aumentada até 40 graus, e a umidade relativa do ar é baixada a 0% e depois aumentada até 85%. Este teste roda durante 24 horas e ao final tem-se um relatório mostrando se a peça funcionou bem ou se apresentou problemas quando as características ambientais foram modificadas. Este, por precisar de câmaras especiais, é feito por amostragem e são testadas três peças de cada modelo sendo fabricado por dia. Figura 18: Câmara onde o teste ambiental é executado. Figura 19: Detalhe do display da câmara ambiental mostrando os testes já executados e o em execução. O teste de confiabilidade é outro teste que nunca vimos em outra fábrica (ou, da mesma forma, se existe em outras fábricas que visitamos, ninguém nunca nos mostrou). Este teste consiste de um burn-in de 168 horas (ou seja, 7 dias consecutivos), com a peça rodando sob temperatura ambiente e rodando uma bateria de programas de testes. Este teste também é feito por amostragem, onde são testadas 10 placas por dia de cada modelo que está sendo fabricado. O teste de vibração tem como objetivo simular o transporte das placas da ABIT na mais severas situações. O testador pega uma caixa contendo várias placas dentro devidamente embaladas e executa dois testes, de uma hora de duração cada. O primeiro teste é de freqüência variável, onde a caixa é sacudida em freqüências de 10 Hz a 60 Hz (ou seja, 10 sacudidas a 60 sacudidas por segundo), permanecendo em cada freqüência por 10 minutos. O segundo teste efetuado é o de freqüência fixa, onde a caixa fica balançando a 100 Hz por uma hora. 20 caixas de cada modelo por dia passam por este teste. Ao final de cada teste, a caixa é aberta para verificar se houve danos físicos nas caixas dos produtos e nos produtos em si e os produtos são testados para ver se estão funcionando adequadamente. O último teste é o de queda, onde uma caixa contendo várias placas em suas respectivas embalagens é literalmente jogada no chão para ver o que acontece. Cada caixa é jogada ao chão de uma altura de 76 cm e o teste é feito para todos os seis lados da caixa. Após o término do teste, a caixa é aberta para verificar como ficou a aparência das caixas dos produtos e as placas são testadas para verificar se estão funcionando corretamente. Este teste é efetuado em 20 caixas de cada modelo que está sendo fabricado por dia. Como podemos ver, aparentemente o controle de qualidade é o diferencial da ABIT. Onze porcento dos empregados da Rolly trabalham no controle de qualidade, enquanto, segundo a ABIT, na fábrica da ASUS este número é de 6%. Outro ponto positivo da ABIT que é importante destacar é que depois do problema de capacitores eletrolíticos estourando e vazando que afeta várias placas-mães – inclusive as da ABIT – eles passaram a só usar capacitores japoneses, mais caros mas que não sofrem deste problema. Para mais informações: http://www.abit-usa.com/

-

Aproveitamos nossa visita à Xangai para visitarmos a fábrica da Kingston. A Kingston possui quatro fábricas: Penang, Malásia, com capacidade para fabricação de 500 mil módulos de memória por mês; Hsin-Chu, Taiwan, com capacidade para fabricação de 1,7 milhão de módulos por mês; Fountain View, Califórnia, EUA, com capacidade de produção de 800 mil módulos de memória por mês; e Xangai, China, com capacidade de produção de 2,5 milhões de módulos por mês. Os módulos são projetados exclusivamente na sede da Kingston, em Fountain View, Califórnia, EUA. É neste mesmo local que os chips com a marca Kingston são encapsulados, isto é, a Kingston compra o wafer de algum fabricante e encapsula o chip em suas instalações e marca a sua própria marca no invólucro. A Kingston também usa chips de terceiros, como Hynix e Elpida. Durante a nossa visita à fábrica de Xangai, os módulos sendo fabricados usavam chips da Hynix. A fábrica de Xangai é a maior, contendo 8 linhas SMT. A Kingston está construindo uma nova fábrica em Xangai, que terá 10 linhas SMT ainda neste ano e 12 linhas em 2005, quando a sua capacidade de produção dobrará, passando a ser de 5 milhões de módulos por mês. A Kingston mantém quatro fábricas, segundo eles, para prevenir problemas de distribuição caso ocorra algum desastre natural ou incêndio. A fábrica que visitamos está localizada na Zona Franca de Waigaoqiao em Xangai. Fábricas localizadas na Zona Franca não pagam o imposto local (VAT, Value Added Tax, o equivalente ao nosso ICMS, que lá é de 17%) se o produto for exportado. Se for vendido no mercado local, o imposto é cobrado. Figura 1: Entrada da Zona Franca de WigaoQiao em Xangai. Figura 2: Fachada da fábrica da Kingston. Figura 3: Política de qualidade da fábrica da Kingston. O processo de fabricação de módulos de memória é similar ao de fabricação de outras placas. A diferença está no fato que módulos de memória não têm componentes de inserção tais como conectores e capacitores eletrolíticos e, portanto, a etapa de inserção manual não existe. A produção de módulos de memória restringe-se à linha SMT. Para entender detalhadamente o processo de fabricação de placas, leia o artigo sobre a nossa visita à fábrica da ABIT em SuZhou, China, onde explicamos o processo em detalhes. Figura 4: Visão geral de algumas das linhas SMT da Kingston. Uma diferença na fabricação de módulos de memória para a fabricação de placas-mães é que as placas de circuito impresso das memórias, ou seja, os módulos sem componentes instalados, entram no processo presos em um painel. Cada painel tem oito módulos. Ao final da fabricação dos módulos, o painel tem que ser cortado para que os módulos possam ser testados e embalados – e usados, naturalmente. Figura 5: Painel contendo oito módulos de memória entrando na linha SMT. Figura 6: Painel saindo da máquina de inserção e entrando no forno de soldagem. Figura 7: Funcionária procura por defeitos de solda nos módulos. Antes de serem separados, os módulos são etiquetados. A etiquetagem e o corte do painel é feito pela mesma máquina. Figura 8: Módulos após terem sido etiquetados. O próximo passo é testar os módulos. Todos os módulos são testados de duas formas. Através de uma máquina, que faz um teste rápido preliminar, e depois um teste funcional em um ambiente real, isto é, em PCs rodando programas de teste de memória. Figura 28: Primeira etapa de testes. Figura 29: Visão geral de uma das áreas de teste da Kingston. Após os módulos terem sido testados eles seguem para serem embalados e ter suas embalagens etiquetadas. A etiquetagem é feita por uma máquina, que imprime a etiqueta na hora dependendo do produto que estiver sendo embalado. Após este processo, os módulos são guardados em caixas de 25 unidades cada. Por fim, uma funcionária confere cada caixa para ver se há 25 módulos em cada caixa e se a etiqueta presente na embalagem do módulo corresponde ao módulo que está de fato dentro da caixa. Figura 30: Máquina etiquetadora. Para mais informações: http://www.kingston.com/

-

Os gabinetes mais incrementados, além de trazerem portas USB em sua parte frontal, como vimos na semana passada, trazem também plugues de entrada de microfone (mic in) e saída para alto-falantes (ou fones de ouvido), recurso que torna muito prático e rápido instalar um microfone ou fone de ouvidos ao PC, pois com este recurso não precisamos tirar o gabinete do lugar e ficar procurando onde encaixar o microfone ou os fones de ouvido (ou caixas de som) na hora da instalação destes periféricos. Retirar o gabinete do lugar é realmente um inconveniente, ainda mais se você tem ele instalado em um móvel feito sob medida, por exemplo. Figura 1: Detalhe de gabinete com portas USB e plugues do som on-board na parte frontal. Para usar esses plugues, sua placa-mãe precisa ter placa de som integrada (ou seja, som on-board). A instalação, no entanto, não é tão simples quanto parece, e iremos explicar na coluna de hoje como ela deve ser feita. Dos plugues sai um conjunto contendo sete fios. Ao final de cada fio há um pequeno conector preto, e neste conector há escrito a função do fio. Você encontrará os seguintes fios: Mic In (ou Mic Data), Ret L, Ret R, L Out (ou Ear L), R Out (ou Ear R) e dois Gnd (ou Ground). Se você observar bem, os fios Ret L e L Out são conectados entre si, o mesmo ocorrendo com os fios Ret R e R Out. Se o seu gabinete tiver também um plugue de entrada de linha (line in), haverá mais dois fios: Line In L e Line In R. Figura 2: Fios dos plugues frontais do gabinete. Você deverá procurar na sua placa-mãe o local de instalação desses fios. Este local está marcado com "Audio", "External Audio", "Ext Audio", "Front Audio", "F Audio" ou similar. Este local consiste em um conector contendo 9 pinos, existindo dois jumpers instalados, fazendo a ligação de alguns destes pinos. A localização exata deste conector varia de placa-mãe para placa-mãe e você precisará do manual da sua placa-mãe para localizá-lo com exatidão. Figura 3: Local da placa-mãe onde os fios do gabinete deverão ser instalados. Para instalar os fios, o primeiro passo é entender o sistema de numeração dos pinos do conector da placa-mãe. Existem no conector nove pinos, mas o conector é considerado de 10 pinos porque um dos pinos foi removido (pino 8). Os jumpers existentes conectam os pinos 5 ao 6 e os pinos 9 ao 10. Como há o espaço sem pino (pino 8), fica fácil descobrir a numeração dos demais pinos. Note que de um lado do conector os pinos têm numeração ímpar (1 a 9) e, do outro, par (2 a 10). Figura 4: Pinagem do plugue da placa-mãe. Remova os jumpers. A conexão dos fios deve ser feita da seguinte forma: Mic In ao pino 1; Gnd ao pino 2 e 3; R Out ao pino 5; Ret R ao pino 6; L Out ao pino 9 e Ret L ao pino 10. Aprenda a instalar as portas USB frontais mostradas na Figura 1.

-

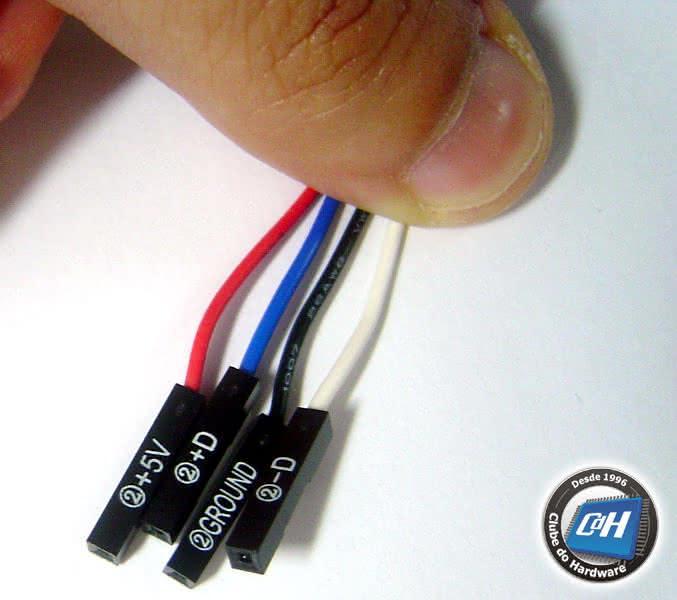

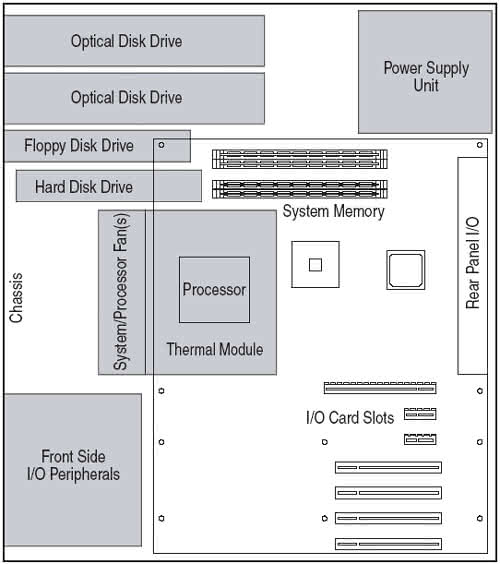

Os gabinetes mais incrementados vêm com portas USB frontais. Para usá-las, você precisa conectá-las à placa-mãe do seu micro. Em nossa coluna de hoje, mostraremos como esta conexão deve ser feita. Atualmente as placas-mães vêm com quatro, seis ou oito portas USB, só que dessas portas todas, normalmente apenas duas ou quatro são soldadas diretamente à placa-mãe, em sua parte traseira. Por conta disso, em geral temos duas portas USB "sobrando" na placa-mãe. Estas portas "sobrando" estão normalmente disponíveis em um conector de 9 ou 10 pinos, como você confere nas fotos. É nesse conector que as portas USB do painel frontal do gabinete devem ser instaladas. Figura 1: Conector USB da placa-mãe. Figura 2: Outro exemplo de conector USB da placa-mãe. O grande problema é que não há padronização entre os diversos fabricantes de placas-mães das funções de cada pino, isto é, o pino 1 do conector de uma placa-mãe pode ter um significado diferente do pino 1 do conector de uma placa-mãe de outro fabricante. Por causa disso, cada fio das portas USB do painel frontal do gabinete usam conectores individuais. Como cada porta USB usa quatro fios, você terá em seu gabinete oito fios vindo do painel frontal, caso o seu gabinete tenha duas portas USB, que é a quantidade mais comum. Figura 3: Fios das portas USB do gabinete. No conector de cada fio há escrito o seu significado, que pode ser +5V (ou VCC ou Power), D+, D- e GND. Além do significado, em cada conector há escrito se o fio pertence à porta 1 (ou A ou X) ou porta 2 (ou B ou Y) do gabinete. O primeiro passo para a instalação é separar os fios de acordo com a porta, isto é, separar os fios em dois grupos: porta 1 e porta 2. Figura 4: Detalhe dos conectores dos fios das portas USB do gabinete. Em seguida, você deve instalar os fios no conector da placa-mãe. O grande problema é saber o significado de cada pino da placa-mãe, já que normalmente isto não está escrito sobre a placa-mãe. Para esta tarefa, você precisará consultar o manual da placa. Lá o significado de cada pino do conector, como mostramos na ilustração. Basta você instalar cada um dos fios (+5V, D+, D- e GND) nos locais indicados no manual. Na placa-mãe usada em nosso exemplo, os fios da porta 1 deverão ser ligados da seguinte forma: +5V no pino 1, D- no pino 3, D+ no pino 5 e GND no pino 7. Os fios da porta 2 deverão ser ligados da seguinte forma: +5V no pino 2, D- no pino 4, D+ no pino 6 e GND no pino 8. Note que o significado de cada pino da sua placa-mãe pode ser diferente deste exemplo e, portanto, você precisará consultar o manual da sua placa. Normalmente os fios de uma porta ficarão de um lado do conector (pinos ímpares) e os fios da outra porta ficarão do outro lado (pinos pares). Figura 5: Manual da placa-mãe. Clique aqui para aprender a instalar os conectores frontais de áudio do gabinete.

-

Com certeza se o seriado Profissão: Perigo tivesse sido criado e rodado em 2004, o McGyver teria um canivete suíço como este, que tem 64 MB ou 128 MB de memória flash USB, que é um verdadeiro sonho de consumo. Este nosso teste foge completamente do perfil dos nossos testes normalmente publicados aqui no Clube do Hardware, mas nós julgamos este teste muitíssimo interessante, já que este produto é fabricado pela lendária Victorinox – responsável pela criação dos famosos canivetes suíços desde 1884 – e, com certeza, despertará o desejo de todos os nossos usuários. A sua praticidade fala por si só. Amantes de canivetes suíços tendem a carregá-lo a todos os lugares. Desta forma, aonde quer que você vá, você terá à mão uma memória de 64 MB ou 128 MB, podendo transportar arquivos com facilidade e de uma maneira infinitamente mais prática e menor que um disquete, sem falar na capacidade de armazenamento quase 90 vezes maior que um disquete de 1,44 MB, comparado ao modelo de 128 MB. Figura 1: Caixa original do canivete suíço com memória USB. Oficialmente chamado Swissmemory, o canivete tem as seguintes ferramentas: memória USB de 64 MB ou 128 MB, faca pequena, lixa, tesoura, caneta e lanterna. A Victorinox comercializa ainda um modelo sem as ferramentas cortantes (faca, lixa e tesoura) para que você possa carregar o canivete em vôos aéreos. Este modelo é chamado Flight e é um pouco mais barato. O canivete é realmente pequeno (6 cm de comprimento) e realmente muito prático. Junto com o canivete vem um cabo de extensão, para caso a porta USB esteja atrás do PC em ângulo de difícil acesso para a instalação do canivete. Figura 2: Canivete suíço e o seu cabo de extensão. Figura 3: Realmente portátil, com apenas 6 cm de comprimento. A memória USB é destacável, o que torna o canivete ainda mais interessante, pois oferece uma indiscutível praticidade. Figura 4: Para maior praticidade, a memória pode ser destacada do canivete. Nas próximas fotos você confere as demais ferramentas deste canivete. Figura 5: Tesoura, lixa e faca. Figura 6: Caneta. A lanterna é ligada pressionando-se o símbolo da Victorinox. Figura 7: Lanterna. Pode parecer que já mostramos tudo que este canivete oferece, mas isto não é verdade. Em sua memória vem um programa chamado Secure Lock, que configura as funcionalidades da memória. Versões de memória: 64 MB e 128 MB Ferramentas: Faca pequena, lixa, tesoura, caneta e lanterna. Há uma versão sem a faca, lixa e tesoura, chamada Flight, para que você possa carregar o canivete em vôos aéreos. Recursos extras: Cabo extensor USB e programa Secure Lock. Mais informações: http://www.swissbit.com Preço sugerido no mercado europeu: € 64 (modelo Flight, 64 MB), € 78 (modelo Flight, 128 MB), € 69 (modelo completo, 64 MB) e € 82 (modelo completo, 128 MB). Programa Secure Lock O programa Secure Lock que acompanha o canivete permite que você configure uma senha para impedir que pessoas não autorizadas leiam os dados presentes na memória. O programa permite criar dois tipos "partições" na memória, uma pública, que qualquer um pode acessar, e uma privada, que somente quem souber a senha pode acessar. Há também no programa uma ferramenta de reparo, que "zera" a memória e testa a mesma para ver se ela está 100% funcional. Outra ferramenta disponível no programa é a transformação da memória USB em um disco de boot, permitindo que você dê boot através da memória USB. Esta opção é realmente muito interessante para os técnicos em manutenção. Figura 8: Programa Secure Lock. Desempenho Nós recebemos para teste o modelo com 128 MB de memória. Testamos o desempenho da memória USB do canivete usando o programa Sandra 2004 versão 9.89 (http://www.sisoftware.net), em um micro com portas USB 2.0. Usando arquivos de 2 MB, a memória atingiu um desempenho de 956 KB/s para a leitura e 546 KB/s para a escrita, valores parecidos com outras memórias USB disponíveis no mercado. Conclusões O canivete suíço com memória USB é uma idéia fantástica, pois é um produto prático e realmente útil. Como comentamos, quem gosta de canivete suíço acaba carregando-o consigo a todos os lugares, e ter uma memória USB de 64 MB ou 128 MB à mão é sempre útil. O canivete é pequeno e leve, o que o torna ainda mais atraente. O fato da memória poder ser destacada do canivete é realmente muito conveniente. O programa que acompanha o canivete é outro destaque, já que ele permite criar "partições" na memória do canivete, uma pública e uma privada, com senha de acesso.

-

Os spams, e-mails não solicitados, são uma praga. Além de entupirem a nossa caixa de e-mail e nos fazerem perder muito tempo apagando as benditas mensagens, não oferecem nada de concreto a não ser golpes, soluções questionáveis para problemas sexuais, produtos que não queremos e coisas do gênero. De fato, a maior parte dos e-mails que circulam na Internet é spam, fazendo com que servidores tenham de ser superdimensionados para aguentarem o tráfego adicional indesejado, acarretando em um aumento no consumo elétrico. Se pensarmos na quantidade de servidores de e-mails espalhados pelo mundo, temos um real problema ecológico que pouco é discutido e que já exploramos em nosso editorial “Porque somos a favor da criminalização do spam”. Existem vários programas e soluções para “matar” spam. Mas hoje queremos discutir o que poucos usuários comuns sabem: afinal, como se pega spam? como, tendo acabado de criar uma conta de e-mail “limpa”, passamos a receber spam? Ou seja, como as pessoas que fazem spam conseguem o nosso endereço de e-mail? Por incrível que pareça, são poucos os métodos usados para se conseguir capturar o nosso endereço de e-mail. Com isto, se tivermos o cuidado necessário é possível ter uma caixa postal sem spam. Vamos a eles. Robôs de captura de endereços de e-mail O método mais usado para conseguir e-mails para se fazer spam é usar um programa do tipo “robô” que varre a web em busca de endereços de e-mail. Isto significa o seguinte. Se você publicar o seu endereço de e-mail em algum site na Internet, como redes sociais, fóruns, sites de classificados, sites de reclamação, página de contato de um site ou blog etc. inevitavelmente começará a receber spam. E uma vez recebendo spam, já era, pois seu endereço de e-mail estará em uma lista que será emprestada, divulgada ou até mesmo vendida a outros spammers (pessoas que fazem spam). Se você realmente precisar publicar um endereço de e-mail em um site, escreva-o de forma a enganar os robôs de spam. Há várias formas de se fazer isto. Supondo que o seu e-mail é [email protected], você pode publicar o seu e-mail no site de uma forma alternativa. Alguns exemplos: nome at provedor dot com dot br nome em provedor ponto com ponto br nome#provedor.com.br nome [arroba] provedor [ponto] com [ponto] br Como os robôs de busca varrem a web em busca do símbolo de arroba (@), essa dica funciona que é uma beleza. Você já deve ter reparado que muitos sites de empresas não têm endereço de e-mail para contato, mas sim um formulário, inclusive com possibilidade de selecionar o departamento que você deseja entrar em contato. Um dos motivos que as empresas usam formulários em vez de divulgarem seus endereços de e-mail é justamente evitar o spam, já que no formulário o e-mail da empresa não é divulgado. Portanto, se você tem um site na Internet, a dica é usar formulários em vez de divulgar seus e-mails de contato (ou, se divulgar os e-mails de contato, use a dica acima). Robôs de “chute” de endereços de e-mail Outro tipo de robô de spam “chuta” endereços de e-mail baseados em nomes comuns que são configurados em um dicionário. Aqui mesmo no Clube do Hardware, analisando os logs do nosso servidor de e-mails, vemos inúmeras tentativas de envio de e-mails para contas inexistentes baseadas nesse método. Isto é válido tanto para contas genéricas como sac@, diretoria@ e suporte@ como para nomes comuns, como rodrigo@, fernanda@, bruno@ etc. Por esse motivo, se você tem um site ou blog, recomendamos que não configure endereços de e-mails genéricos, pois certamente tais caixas postais receberão spam na base do “chute”. Da mesma forma, idealmente o seu endereço de e-mail não deve ser um que seja fácil de “chutar” por um envio em massa baseado em palavras de dicionário, como um endereço contendo apenas o seu nome ou sobrenome. Por esse mesmo motivo, se você tiver um site ou blog, nunca utilize configuração de “catch all”. Esta é uma configuração que permite que qualquer e-mail enviado ao seu domínio seja encaminhado a um endereço de e-mail específico. Assim, se alguém enviar um e-mail a um endereço que não existe, em vez de este e-mail retornar com uma mensagem de erro de conta inexistente, ele será aceito encaminhado a uma conta existente. Como o servidor aceitará e-mails enviados a qualquer endereço, sua caixa postal ficará lotada de spam muito rapidamente, pois robôs de spam “chutam” endereços de e-mail, como explicamos. Configuração de redes sociais Em redes sociais como o Facebook e o LinkedIn, é possível configurar para que o seu endereço de e-mail seja mostrado a qualquer um, a contatos mútuos ou então a ninguém, entre outras opções eventualmente disponíveis. Recomendamos que você configure todas as redes sociais que participe a não mostrar o seu endereço de e-mail a ninguém. E-mails em massa Na guerra contra o spam, amigos podem se tornar inimigos, sem saberem. Com certeza você já deve ter recebido inúmeras mensagens repassadas por amigos contendo uma interminável lista de e-mails de outras pessoas que também receberam aquela mesma mensagem. Ou então é um e-mail de divulgação de algo, que a pessoa, em vez de utilizar o campo “Cópia Oculta”, “BCC” ou “CCO” (Blind Carbon Copy/Cópia Carbono Oculta), que oculta a lista de destinatários do e-mail, utiliza, por engano ou por desconhecimento, o campo “Para”, “Cópia” ou “CC” (Cópia Carbono). Essa lista de e-mails é um prato cheio para os spammers, pois ali está, sem nenhum trabalho, uma lista fresquinha de endereços de e-mail válidos. Incluindo o seu! Ao receber mensagens deste tipo, o que você deve fazer é explicar para o remetente que enviar uma mensagem com a lista de destinatários “aberta” (ou seja, com os e-mails inseridos nos campos “Para” ou “CC”) é ruim pois divulga os endereços de e-mails para possíveis spammers. O correto, ao enviar uma mensagem para várias pessoas simultaneamente, é colocar os endereços de e-mail no campo “Cópia Oculta”, “BCC” ou “CCO”, que faz com que a lista de destinatários não seja divulgada. Como a lista de destinatários não é divulgada, não é possível que o spammer capture a lista de e-mails. Cadastros em sites da Internet Outra maneira muito comum de se pegar spam é quando você faz um registro em algum site ou então baixa algum programa shareware ou freeware que necessita de registro para funcionar. Em sites que necessitam de registro para você navegar ou então postar mensagens em seu fórum, você é obrigado a cadastrar seu endereço de e-mail. Este fato isoladamente não faz com que você passe a receber spam, pois normalmente sites que pedem registro normalmente não enviam e-mails não solicitados aos usuários cadastrados. Entretanto, quando você se cadastra em um site deste tipo, normalmente há, na página de registro, caixas de verificação contendo perguntas como "Gostaria de receber e-mails contendo promoções de nosso site?" ou "Gostaria de receber promoções de nossos parceiros?". Se você encontrar caixas de verificação como estas durante o processo de registro, trate de desmarcá-las, ou você passará a receber spam! O fato é que essas caixas aparecem já marcadas e os usuários mais apressadinhos, doidos para terminar logo o processo de registro para usufruir do site (ou programa), simplesmente não observam a existência de tais caixas de verificação. Outro problema é o fato de muitos usuários não sabem ler inglês muito bem e, em sites estrangeiros ou em programas em inglês, pode ser que o usuário não identifique que as caixas que autorizam o envio de spam. Com isto, simplesmente clicam em prosseguir (“Next”) sem se atentarem ao fato de que acabaram de autorizar o envio de spam. Tecnicamente falando, este procedimento é chamado “opt-in”, ou seja, você optou por receber e-mails com mensagens publicitárias. Normalmente os e-mails enviados por conta da sua “solicitação” vêm com uma mensagem do tipo “Você está recebendo este e-mail por ter solicitado. Para remover seu e-mail visite...” ou o equivalente em inglês. Cadastros em lojas físicas O mesmo cuidado descrito no tópico anterior é válido para lojas físicas. Atualmente é muito comum, ao efetuar uma compra, o vendedor solicitar o seu endereço de e-mail. Você começará a receber e-mails com propaganda da loja em seguida. Em alguns casos, o cadastro de um endereço de e-mail é acompanhado com alguma promoção ou desconto. Não existe almoço grátis: a promoção é oferecida para que a loja possa passar a te bombardear com propagandas. A não ser que estejam oferecendo desconto e este valha a pena, não informe o seu endereço de e-mail. Ou então crie uma conta de e-mail apenas para esse tipo de cadastro. Cuidado ao pedir para excluir seu e-mail Você deverá tomar muito cuidado antes de clicar em mensagens do tipo “clique aqui para remover o seu e-mail” ou “responda a este e-mail com a palavra remover”. As principais técnicas para a coleta de endereços de e-mail são o uso de robôs, como discutimos anteriormente, e da compra de listas com milhões de e-mails de outros spammers que já fizeram este trabalho. O spammer, no entanto, ainda não sabe se a lista de endereços de e-mail é válida ou não. Uma técnica utilizada há muito tempo para verificar se os e-mails são válidos é justamente colocar uma mensagem do tipo “clique aqui para remover seu e-mail” ou “responda a este e-mail com a palavra remover”. Se você clicar no link, estará verificando que o seu endereço de e-mail é válido! Com isto, o spammer acaba criando uma nova lista de endereços de e-mail válidos! Como consequência, ao clicar em mensagens como essa, você passará a receber ainda mais spam! Desta forma, antes de clicar em um link desse tipo, você deve verificar antes quem está enviando a mensagem. Se for de um site onde você se cadastrou recentemente ou de uma loja onde você fez uma compra e o vendedor pediu o seu endereço de e-mail, então é provavelmente seguro clicar no link de descadastramento. Do contrário, não clique nem abra o endereço mencionado, ou você passará a receber ainda mais spam. Ou seja, simplesmente apague o spam! Palavras finais Se você está atualmente recebendo muito spam, as dicas de hoje terão pouca eficiência, pois seu endereço de e-mail já está incluído em listas de spam. Desta forma, o ideal é criar uma nova caixa postal e passar a adotar os conselhos dados

-

Nosso 3º dia de IDF começou com uma apresentação de Sean Maloney, vice-presidente executivo e gerente geral do grupo de comunicações da Intel, sobre as novidades na área de pesquisa e desenvolvimento de redes. Foram feitas alguns anúncios bem interessantes. Para começar, o desenvolvimento de memórias flash de 90 nm, que serão lançadas no mercado no 3º trimestre deste ano. Diminuindo o tamanho dos transistores de 130 nm para 90 nm aumentará o desempenho da memória, o que sensivelmente melhorará o desempenho de celulares e PDAs que usarem memórias flash de 90 nm. Figura 1: Comparação da pastilha de silício da memória flash de 90 nm com a memória flash de 130 nm. Foi apresentado ainda um novo chip de vídeo 3D para PDAs, nome-código Carbonado, que promete ter um desempenho de 3 milhões de polígonos por segundo e será lançado ainda neste semestre. Vimos ao vimo um jogo de primeira pessoa (estilo Doom) rodando com um bom desempenho em um protótipo de PDA usando este novo chip. Sean apresentou ainda uma placa de rede Ethernet de 10 Gbit/s usando um chip Intel de 2ª geração, fazendo a placa de rede ficar menor que as placas de 10 Gbit/s de primeira geração. Foi mostrado ainda um switch Ethernet de 10 Gbit/s. Figura 2: Placa de rede Ethernet de 10 Gbit/s de 2ª geração. Figura 3: Switch Ethernet de 10 Gbit/s. Em seguida, assistimos a uma apresentação de Pat Gelsinger ("Pesquisa e Desenvolvimento: Arquitetando a Era do Tera"), onde foram apresentadas várias novidades tecnológicas que estarão incorporadas nos processadores Intel nos próximos anos. Para demonstrar a necessidade de poder computacional, Pat convidou ao palco Phillip Slusallek, professor de computação gráfica da Universidade de Saarland, Alemanha, que nos explicou a diferença entre rasterização (rastering) e traçado de raios (ray tracing), que são duas técnicas de se renderizar imagens 3D. Atualmente o primeiro método é usado, o grande problema, porém, é que o resultado final não fica perfeitamente realista, por conta dos reflexos. Figura 4: Diferenças entre rasterização e traçado de raios. Na apresentação foram mostrados o modelo de dois carros (New Beetle) estacionados lado a lado. O vermelho, que usa rasterização, não reflete o que está ao seu redor. Já o azul, que usa traçado de raios, reflete o que há a sua volta, obtendo um aspecto muito mais realista. Compare nas Figura 5 e 6. Figura 5: Detalhe do carro renderizado usando rasterização. Figura 6: Detalhe do carro renderizado usando traçado de raios. O grande problema de se usar traçado de raios é a complexidade dos cálculos envolvidos. Cada imagem demora minutos ou mesmo horas para ser renderizada. Com isto, torna-se impossível atualmente usar a técnica de traçado de raios para a renderização de imagens 3D em tempo real, como para jogos ou CAD. Slusallek demonstrou um sistema onde ele conseguia renderizar imagens 3D em tempo real. Mas, para isto, usou uma "singela" configuração: 22 racks cada um contendo 2 processadores Xeon de 2,2 GHz. O sistema tinha uma capacidade total de processamento de 400 Giga FLOPS. Figura 7: Pat Gelsinger e Phillip Slusallek ao lado da configuração usada para renderizar a animação da Figura 6 em tempo real. Ou seja, a renderização de imagens 3D ainda mais realistas, usando a técnica de traçado de raios, é um exemplo de aplicação que se beneficia de aumento do poder computacional que poderá ser introduzido nos próximos anos. Outro dado muito interessante apresentado foi o seguinte. Na técnica de rasterização, quanto mais polígonos a imagem 3D tem, menor é o desempenho de renderização, isto é, menos quadros por segundo são gerados. Já na técnica de traçado de raio, há pouca queda no desempenho quando aumenta-se o número de polígonos. Para imagens pouco complexas, a técnica de rasterização tem um desempenho muito superior. Mas quando estamos falando de imagens complexas, na ordem de 1 bilhão de polígonos, a técnica de traçado de raio acaba se saindo melhor que a técnica de rasterização. Com uma grande vantagem: o desempenho aumenta proporcionalmente ao número de processadores da máquina. Vemos isto no gráfico da Figura 8, onde a linha amarela mostra o desempenho da rasterização e a verde, do traçado de raios (para um, dois ou quatro processadores). Figura 8: Desempenho da rasterização versus traçado de raio. A deixa aqui é clara: como a Intel deverá começar a produzir em breve processadores Xeon e Itanium com múltiplos núcleos (clique aqui para saber mais sobre este assunto), esta nova safra de processadores deverá aumentar o desempenho de estações de trabalho de alto desempenho usadas na renderização de imagens 3D usando a técnica de traçado de raios. Pat Gelsinger mostrou uma tecnologia chamada Helper Threads, que consiste em um compilador que analisa o programa e o otimiza de forma que as instruções sejam ordenadas de forma que o processador não tenha que esperar a memória ficar pronta para entregar ou receber um dado. Como a memória RAM é muito mais lenta que o processador, o que acaba ocorrendo é que grande parte do tempo o processador tem de parar e esperar até a memória RAM entregar um dado ou ficar pronta para receber um dado. Isto ocorre sobretudo quando há um erro de cache (cache-miss), isto é, quando o dado requisitado não estava dentro da memória cache, que é uma memória que consegue se acessada na mesma velocidade do processador. Para esta tecnologia funcionar, o processador também tem de tê-la. Gelsinger apresentou o protótipo de Itanium com esta tecnologia em uma demonstração ao vivo desta tecnologia fazendo consultas a um banco de dados DB2, onde o sistema com o Helper Threads mostrou-se realmente mais eficiente. Na máquina sem esta tecnologia, o demo demorou 50,9 segundos para ser executado e ocorreram 411 milhões de erros de cache. Já na máquina com esta tecnologia, o demo demorou 45,9 segundos e ocorreram 314 milhões de erros de cache. Polarização Adaptativa de Corpo Outra tecnologia apresentada foi a polarização adaptativa de corpo (adaptative body biasing), que será usada na construção de futuros transistores usados em microprocessadores. Atualmente um dos maiores problemas encontrados na fabricação de processadores é a corrente de fuga de seus transistores. O que acontece é o seguinte. Quando o transistor está em sua posição de "desligado", uma pequena corrente continua passando (chamada corrente de fuga), que faz com que uma parte significativa da potência dissipada pelo processador seja causada por esta corrente. Isto significa que se não houvesse corrente de fuga, os processadores dissipariam menos potência, isto é, menos calor seria gerado. A ideia apresentada consiste em fazer com que, quando o transistor estiver desligado, que ele seja inversamente polarizado (isto é, "ligado invertido") a fim de diminuir a incidência da corrente de fuga. Gelsinger falou ainda nos progressos do rádio adaptativo, mas como já explicamos esta tecnologia em nossa cobertura do IDF passado, não a explicaremos novamente aqui. Uma das grandes novidades deste IDF foi o lançamento de um consórcio para a criação do barramento USB sem fio, chamado wireless USB ou simplesmente WUSB. A ideia do USB sem fio é fazer a ligação de periféricos USB ao PC sem fio. Ao computador será conectada uma antena (via porta USB, naturalmente), também chamada HWA (Host Wire Adaptor). Já a antena onde os periféricos são instalados é chamada DWA (Device Wire Adaptor), com capacidade para conexão de até 127 periféricos. Em uma mesma antena podem ser instalados vários periféricos USB, tais como impressoras, câmeras, etc. Ou seja, os periféricos USB existentes hoje funcionarão sem problemas no USB wireless: em vez de ligar a impressora USB ao micro você a instalará na antena. A taxa de transferência é a mesma do USB 2.0: 480 Mbit/s, para uma distância de até 3 metros entre as antenas, o que é uma taxa de transferência impressionante. À medida em que as antenas se separam mais do que isto, a taxa de transferência cai. A ideia é concorrer com o Bluetooth, que está tentando (ao nosso ver, sem muito sucesso) fazer a conexão entre o PC e periféricos usando tecnologia wireless. A grande vantagem do USB wireless, e daí a importância deste lançamento, é a sua taxa de transferência: o Bluetooth transfere dados somente a 1 Mbit/s. Os primeiros produtos WUSB deverão começar a chegar ao mercado no final de 2005, de acordo com a previsão da Intel. A comunicação do Wireless USB funciona na faixa de freqüência UWB (Ultra Wide Band, de 3,1 GHz a 10,6 GHz). Já a tecnologia Bluetooth funciona na faixa de 2,4 GHz, a mesma usada pela comunicação sem fio IEEE 802.11 (Wi-Fi). O consórcio PCMCIA está disposto a introduzir um novo formato de cartões de expansão para notebooks, chamado Express Card. Estes cartões podem ter dois tamanhos: Express Card/34 (34 mm) e Express Card/54 (54 mm). Figura 9: Placas Express Card. A da esquerda é uma de 54 mm, para smart card. Há várias diferenças do Express Card para o PC Card (mais conhecido como PCMCIA). O Express Card transfere dados de maneira serial e conecta-se diretamente ao barramento USB 2.0 ou ao barramento PCI Express. Já no PC Card a comunicação é paralela e necessita de um circuito controlador no notebook. Como o Express Card é ligado diretamente ao USB 2.0 ou ao PCI Express, este circuito não é necessário. Como a comunicação é serial, menos pinos são necessários: 26, contra 68 no PC Card. Isto simplifica a construção de placas e notebooks, já que menos fios são necessários na placa de circuito impresso do notebook. Como há menos pinos e o cartão é menor, o custo de fabricação de um cartão Express Card é também menor, enquanto o seu desempenho é maior. Na feira de tecnologia que ocorre paralelamente ao IDF, a Seagate apresentou um modelo de disco rígido SAS (Serial Attached SCSI), tecnologia que vimos no IDF Spring 2003 (clique aqui para conhecer esta tecnologia em detalhes). O HD apresentado, Savvio, roda a 10.000 rpm, tem cache de 8 MB, é de 2,5 polegadas e será encontrado em duas capacidades: 36 GB ou 73 GB. Durante o terceiro trimestre serão lançados os modelos SCSI (Ultra320) e Fibre Channel e, no quarto trimestre, será lançado o modelo SAS de 3 Gbit/s (aproximadamente 375 MB/s). Figura 10: Disco rígido Savvio da Seagate, usando tecnologia SAS. De resto, embora nesta edição do IDF a feira tivesse mais expositores, achamos ela fraca para a nossa área, visto que a maioria dos expositores era de desenvolvedores procurando parceiros para negócios tais como desenvolvimento e fabricação de produtos. Os demais expositores que poderiam nos interessar, como NVIDIA, ATI, Samsung, Hynix, Elpida, Kingston e ALi, não apresentaram nada de novo. Por exemplo, a NVIDIA, que anunciou novos chips gráficos PCI Express, não os mostrou nesta feira.

-

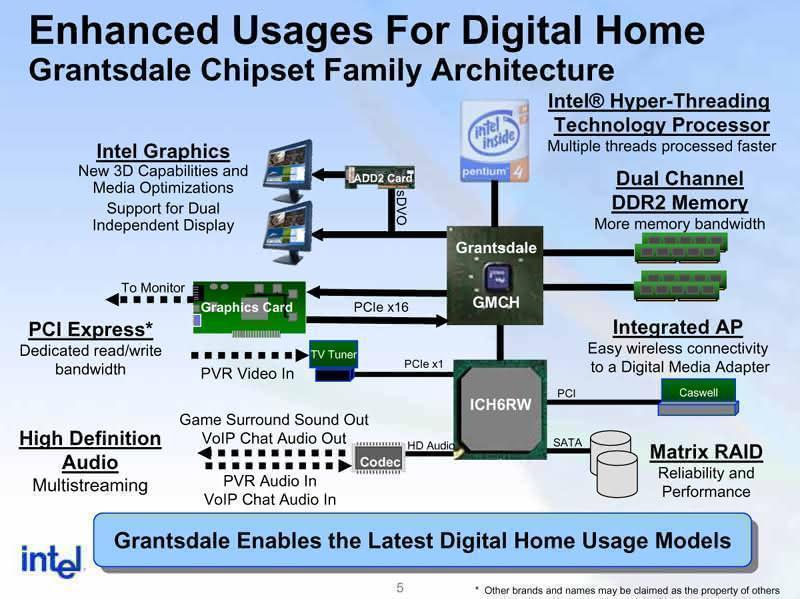

Começamos o nosso segundo dia de IDF assistindo a uma apresentação do novo sistema de áudio que a Intel estará implementando em seus próximos chipsets, Grantsdale e Alderwood. Antigamente chamado Azalia, o nome comercial deste sistema de áudio é HD ou High Definition (alta definição). Este áudio on-board tem duas novas características: o multi-streaming (permite enviar mais de um sinal de áudio a mais de um receptor de áudio distinto, por exemplo, assistir um DVD na sala transmitindo o áudio via wireless e fazer uma conexão de voz sobre IP no computador) e a alta qualidade. A alta qualidade é possível hoje, mas para isto a placa-mãe tem que ter um controlador a parte, como o VIA Envy24, por exemplo. Com esta nova tecnologia, o áudio de qualidade (7.1, taxa de amostragem de 192 kHz e resolução de 24 bits) será produzido pelo próprio chipset (ponte sul), necessitando apenas de um codec externo para efetuar a conversão digital/analógica e analógica/digital necessária. Inclusive a C-Media anunciou ontem um codec compatível com o áudio HD da Intel, o C-Media 9880. A Intel está promovendo o áudio de alta definição em parceria com o famoso laboratório Dolby, que criou três "níveis" de áudio para o PC em conjunto com o áudio HD da Intel: Dolby Sound Room, Dolby Home Theater e Dolby Master Studio representando o usuário iniciante, o usuário intermediário e o usuário avançado, respectivamente (classificações de acordo com o uso de áudio digital). As características são as seguintes: Dolby Sound Room: áudio de 2 canais com capacidade para as tecnologias Dolby Virtual Speaker e Dolby Head Phones. Estas duas tecnologias simula o áudio 5.1 usando apenas 2 caixas de som, baseado no Dolby Pro Logic II. Relação sinal/ruído mínima de 75 dB. Dolby Home Theater: áudio no formato 5.1 com relação sinal/ruído mínima de 85 dB, baseado no Dolby Pro Logic II. Dolby Master Studio: áudio no formato 7.1 com relação sinal/ruído mínima de 95 dB, baseado no Dolby Pro Logic IIx, e tecnologia Dolby Digital Live. Algo muito interessante sobre a tecnologia Dolby Pro Logic II é que ela permite simular áudio 5.1 (ou 7.1 no caso do Dolby Pro Logic IIx) mesmo que a fonte de entrada tenha apenas 2 canais (como é o caso do CD, por exemplo), usando um sistema de filtros. Já a tecnologia Digital Live é a tecnologia de streaming dos laboratórios Dolby, usada na transferência de uma música que esteja no computador para um aparelho de som localizado na sala via wireless, por exemplo. A ideia é que os usuários, apenas olhando para a caixa da placa-mãe, já saibam qual é a qualidade do áudio da placa, observando apenas qual é a logomarca Dolby presente (Sound Room, Home Theater ou Master Studio). Vimos (ou melhor, ouvimos) alguns demos e ficamos impressionados com a tecnologia Dolby Pro Logic IIx, que separa em oito canais (formato 7.1) músicas de CDs, que são gravados em apenas dois canais. O resultado é realmente impressionante, fica até parecendo que o CD foi originalmente gravado no formato 7.1 Pete Voigt, engenheiro principal da Intel, fez a apresentação da nova tecnologia de memórias para servidores que a Intel está criando, chamada Fully Buffered DIMM ou simplesmente FB-DIMM. A Intel ainda está apresentando ao JDEC, órgão responsável pela padronização de memórias, esta tecnologia, que só deverá chegar ao mercado no final de 2005 ou início de 2006. A ideia dos módulos FB-DIMM é fazer a comunicação entre o controlador de memória (chipset) e os módulos de memória serial, da mesma forma que ocorre com o PCI Express. Com isto, a quantidade de fios diminui, além de ser possível a criação de mais canais de memória, o que aumenta o desempenho de acesso à memória. Com esta tecnologia é possível ter até 8 módulos por canal e até 6 canais. A comunicação serial dos módulos FB-DIMM usa 10 pares de fio na transmissão de dados do chipset ao módulo de memória e 12 ou 14 pares de fio na transmissão de dados do módulo de memória ao chipset. Cada par de fio usa transmissão diferencial, isto é, em um fio é enviado o sinal e no outro o inverso do sinal, da mesma forma que ocorre na transmissão em redes de par trançado. Clique aqui para ler um tutorial nosso que explica em detalhes como esse esquema de transmissão funciona. Outro detalhe interessante é que é usado caminhos separados para a transmissão e para a recepção de dados. Nos módulos de memória DIMM convencionais é usado um único caminho tanto para a transmissão quanto para a recepção. O esquema usado nos módulos FB-DIMM ajuda no aumento do desempenho do sistema de memória. Inicialmente os módulos FB-DIMM usarão memórias DDR2, migrando para DDR3 possivelmente no final de 2006 ou início de 2007. Interessante notar que os módulos FB-DIMM terão o mesmo tamanho dos módulos DDR2, e não precisarão ser alterados quando as memórias DDR3 forem lançadas. Figura 1: Funcionamento dos módulos FB-DIMM. Há várias vantagens no uso de módulos FB-DIMM em servidores. A primeira é a simplificação da construção da placa-mãe do servidor. Apesar de o soquete usado ser o DDR2, de 240 pinos, o FB-DIMM usa apenas 69 destes pinos, ficando muito mais fácil fazer o roteamento (desenho das trilhas da placa de circuito impresso). Na Figura 2 nós vemos o roteamento necessário para ligar a ponte norte aos soquetes DDR2, usando apenas um canal. É necessário usar 3 camadas de placa de circuito impresso. Figura 2: Roteamento de módulo DIMM DDR2, 1 canal. Já na Figura 3 nós vemos o roteamento necessário para ligar a ponte norte aos soquetes FB-DIMM, usando dois canais. Além de menos fios, usa-se apenas 2 camadas de placa de circuito impresso. Note que mesmo usando 2 canais, usa-se menos fios do que o DDR2 usando apenas 1 canal. Figura 3: Roteamento de módulo FB-DIMM, 2 canais. Outras duas vantagens dos módulos FB-DIMM sobre os módulos DDR2-DIMM são a capacidade máxima e o desempenho. Na Figura 4 nós temos um resumo disto. O máximo que é possível construir usando um controlador de memória com módulos DDR2 convencionais é um sistema com capacidade máxima de 8 GB (quatro soquetes, dois por canal), com uma taxa de transferência máxima de 10 GB/s, se forem usadas memórias DDR2-800. Já com módulos FB-DIMM, a capacidade máxima pula para 192 GB (48 módulos, oito por canal) e a taxa de transferência máxima pula para 40 GB/s, usando o mesmo tipo de memória. A taxa de transferência é aumentada porque é possível ter até 6 canais de memórias FB-DIMM, porém apenas 2 canais DDR2. Figura 4: Comparação de capacidade entre DDR2-DIMM e FB-DIMM. A ideia das memórias FB-DIMM é realmente interessante e deve solucionar a demanda de servidores por mais memória e mais taxa de transferência, e é interessante saber que até o momento vários fabricantes já falaram que construirão módulos com esta tecnologia, como a Samsung, a Elpida, a Infineon, a Micron, a Hynix, a Nanya e a Kingston. Continue lendo: IDF Spring 2004 - 3º Dia

-